Матрицы и камеры

Производителей цифровых камер больше, чем тех кто «умеет» делать матрицы. Схем используемых объективов не много. Но споры о том, чьи фотографии лучше не прекращаются. Алгоритмы преобразования сигнала с матрицы «в файл», дизайн и пользовательские функции — то, над чем собственно и могут потрудиться «фирменные» конструкторы.

И все же интересно — много ли зависит от матрицы и могут ли камеры с близкими по характеристикам CCD/CMOS (или даже идентичными) сильно отличаться по фотографическим возможностям и изображению.

Для сравнения были взяты экземпляры распространенных и очень удачных цифровых камер «полупрофессионального» уровня. Все они уже были испытаны ранее и описаны. Технические характеристики и описания: Canon Power Shot G2, Olympus C-5050ZOOM, Casio QV4000 и здесь, Casio QV5700, Nikon Coolpix 5000. Данные о матрицах взяты из этих же материалов, а так же статей о матрицах и итогах года. В прочем SONY и Panasonic не держат секретов об уже выпущенных светочувствительных чипах и найти их описание можно через любую поисковую систему в сети. Труднее установить, что же конкретно установлено в цифровой фотоаппарат.

Труднее установить, что же конкретно установлено в цифровой фотоаппарат.

Отобранные для сравнения аппараты интересны тем, что два из них практически идентичны по конструкции, но имеют матрицы разных производителей и разрешения (Casio), Canon G2 и Casio QV4000 собраны на одинаковых матрицах и объективах, но различны по конструкции и используемым алгоритмам «оцифровки», 5-ти мегапиксельные аппараты собраны на матрицах разных производителей и размеров. Так что есть, что сравнить.

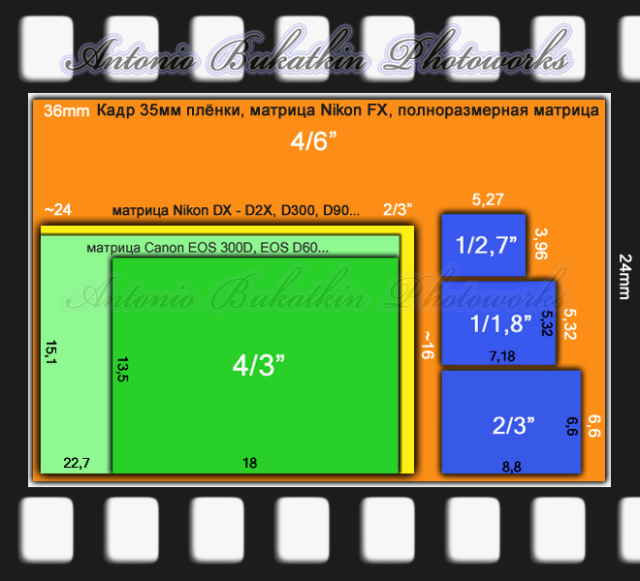

То, что дизайнеры могут по разному использовать ресурсы матриц хорошо видно на примере Canon G2 и Casio QV4000. При одной и той же матрице и объективе, аппараты отличаются максимальным форматом кадра, диапазоном возможных светочувствительностей (у Casio вообще единственное базовое значение ISO) и наличием RAW (у Casio формально RAW нет). Возможно, что такая «искусственная скромность» Casio результат «рыночного соглашения». И это вполне вероятно — ведь множество функций Casio QV4000 скрыты от «рядового пользователя» (смотри здесь) но все же существуют. Прямой конкурент Casio QV5700 с 1/1,8″ матрицей Panasonic — Olympus C-5050 с такой же по размеру и разрешению матрицей от Sony. В Nikon Coolpix 5000 установлена 5 мегапиксельная и в 2/3″ — большая матрица с наибольшим размером отдельного чувствительного элемента — 3,4 микрона. При таком «большом» элементе и матрице максимальная диафрагма в F/8 и то только для широкого угла выглядит скромной в сравнении с F/10 у Olympus с его меньшей матрицей.

Прямой конкурент Casio QV5700 с 1/1,8″ матрицей Panasonic — Olympus C-5050 с такой же по размеру и разрешению матрицей от Sony. В Nikon Coolpix 5000 установлена 5 мегапиксельная и в 2/3″ — большая матрица с наибольшим размером отдельного чувствительного элемента — 3,4 микрона. При таком «большом» элементе и матрице максимальная диафрагма в F/8 и то только для широкого угла выглядит скромной в сравнении с F/10 у Olympus с его меньшей матрицей.

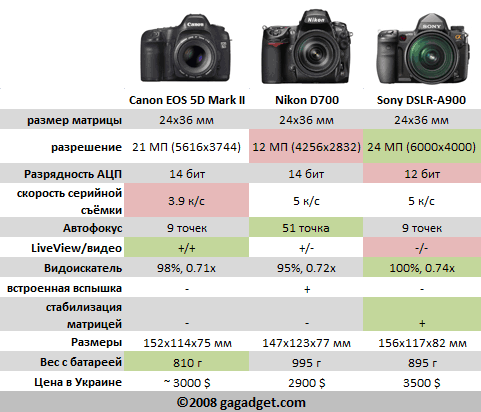

| камера | Canon PowerShot G2 | Olympus С-5050 Zoom | Casio QV4000 | Casio QV5700 | Nikon 5000 |

| матрица | Sony ICX406AQ | Sony | Sony ICX406AQ | Panasonic MN39594PH-L | Sony ICX282 |

| матрица, размер | 1/1,8″ | 1/1,8″ | 1/1,8″ | 1/1,8″ | 2/3″ |

| матрица, эффективных элементов млн | 3,9 | 4,92 | 3,98 | 4,92 | 4,92 |

| Размер элемента мкм | 3,12×3,12 | 2,775×2,775 | 3,12×3,12 | 2,7×2,7 | 3,4×3,4 |

| чувствительность | 50, 100, 200, 400 | 100, 200, 400 | 64 (100) | 50, 100, 200, 400, 800 | 100, 200, 400, 800 |

| кадр | 2272×1704 | 2560×1920 | 2240×1680 | 2560×1920 | 2560×1920 |

| диафрагма | F/2,0 — F/2,5 -F/8 | F/1,8 — F/10 | F/2,0 — F/2,5 -F/8 | F/2,0 — F/2,5 -F/8 | W F/2,8 — F/8 |

Одной из ключевых характеристик цифрового фотоаппарата является его «шумность». Она и была использована для сравнения камер. Про методики определения и оценки шум можно посмотреть здесь и здесь. «Мерой шумности для цифровой фотографии можно считать стандартное отклонение — среднеквадратичное отклонение от среднего, которое выводит Photoshop для всей картинки или выделенной ее области в меню «Гистограмма» (можно смотреть значение среднего и отклонения для яркости L или любого из цветов выбранного цветового пространства RGB, HSB, LAB)».

Она и была использована для сравнения камер. Про методики определения и оценки шум можно посмотреть здесь и здесь. «Мерой шумности для цифровой фотографии можно считать стандартное отклонение — среднеквадратичное отклонение от среднего, которое выводит Photoshop для всей картинки или выделенной ее области в меню «Гистограмма» (можно смотреть значение среднего и отклонения для яркости L или любого из цветов выбранного цветового пространства RGB, HSB, LAB)».

При испытаниях на световой столик укладывалась молочная пленка, запечатанная черными чернилами различной плотности в четырех отдельных зонах. Камера устанавливалась на штатив и производилась съемка с максимальной и минимальной возможной для камеры чувствительностью. Для сглаживания неоднородностей тестового объекта объектив камеры расфокусировался, а диафрагма устанавливалась максимально открытой. Баланс белого устанавливался вручную, экспозиция по экспонометру и с вилкой ±1 ступень выдержки. Съемка производилась в TIFF или RAW. Из снимка вырезались 4 квадратика различной оптической плотности размером 150×150 пикс. Таким образом для каждого фотоаппарата было получено по набору однородных квадратиков для максимальной и минимальной чувствительности. С помощью Photoshop можно определить для каждого из квадратиков значение яркости L и стандартного отклонения яркости dL. Далее не составит труда построить зависимость шума от яркости L. Величиной, характеризующей шум традиционно считается 20хLg(dL/L). Исходные данные в Excel можно посмотреть здесь. Зависимость шума от яркости для каждой камеры представлена в фильме Shockwave Flash:Для удобства сравнения можно «включить» только необходимые камеры и величины светочувствительности.

Из снимка вырезались 4 квадратика различной оптической плотности размером 150×150 пикс. Таким образом для каждого фотоаппарата было получено по набору однородных квадратиков для максимальной и минимальной чувствительности. С помощью Photoshop можно определить для каждого из квадратиков значение яркости L и стандартного отклонения яркости dL. Далее не составит труда построить зависимость шума от яркости L. Величиной, характеризующей шум традиционно считается 20хLg(dL/L). Исходные данные в Excel можно посмотреть здесь. Зависимость шума от яркости для каждой камеры представлена в фильме Shockwave Flash:Для удобства сравнения можно «включить» только необходимые камеры и величины светочувствительности.

Лучший результат при минимальной чувствительности у Nikon 5000. И это не удивительно — его чувствительный элемент наибольший, а система фильтров C-Y-G-M теоретически использует свет более эффективно, чем G-R-G-B. Так же вполне логично и то, что Canon G2 и Casio QV4000 шумят почти одинаково. 5-ти мегапиксельная матрица SONY 1/1,8″ (Olympus C-5050) шумит чуть сильнее конкурента от Panasonic (Casio QV5700). На максимальной чувствительности Nikon 5000 с его ISO 800 уступает только Olympus C-5050 с ISO 400 и лучше других аппаратов с ISO 400 и 800. Так что размер отдельной ячейки все еще важен.

5-ти мегапиксельная матрица SONY 1/1,8″ (Olympus C-5050) шумит чуть сильнее конкурента от Panasonic (Casio QV5700). На максимальной чувствительности Nikon 5000 с его ISO 800 уступает только Olympus C-5050 с ISO 400 и лучше других аппаратов с ISO 400 и 800. Так что размер отдельной ячейки все еще важен.

Дополнительно для визуальной оценки «шумности» приведены фрагменты квадратиков близкой яркости для минимальной возможной чувствительности и разных камер (яркость некоторых фрагментов немного изменена для «удобства» сравнения, у фрагмента Casio QV4000 цвета приведены к «серому», так как ручной баланс «сработал» некорректно):

Olympus C5050ZOOM ISO64 1/100 c F/2,6 | |

Nikon Coolpix 5000 ISO100 1/37 c F/4,8 | |

Canon PS G2 ISO50 1/8 c F/2,5 | |

Casio QV4000 ISO 64 (100) 1/139 c F/2 | |

Casio QV5700 ISO 50 1/93 c F/2 |

Выводы:

1. Большая матрица с большим светочувствительным элементом шумит меньше.

Большая матрица с большим светочувствительным элементом шумит меньше.

2. Шумы Canon G2 и Casio QV4000 очень похожи и если предположить, что у этих аппаратов с одинаковыми матрицами и объективами алгоритмы оцифровки разные, то надеяться на «всесилие математики» в борьбе с шумами пока рано и главное все же матрица.

3. Так как камеры собраны на базе близких по характеристикам матриц (или вообще одних и тех же), то как и в случае с пленкой выбирать следует (в одном классе) тот фотоаппарат, который устраивает вас функционально и просто вам «по душе».

Таблица характеристик матриц цифровых фотоаппаратов

От редакции сайта Vt-tech.eu

Автор данной статьи — Владимир Медведев. Статья была опубликована на личном сайте автора по адресу:

vladimirmedvedev.com/dpi.html

Однако, автор решил полностью переделать сайт и статья пропала.

Статья очень хорошо и доступно раскрывает тему дифракции при высоких значениях диафрагмы, поэтому редакция сайта Vt-Tech никак не могла пройти мимо. Мы извлекли статью из архивов кэширующих сайтов и выложили здесь.

Мы извлекли статью из архивов кэширующих сайтов и выложили здесь.

При экспорте статьи немного пострадали картинки: не все изображения из первоначальной статьи доступны.

Надеемся, что автор статьи не будет возражать против размещения её здесь.

Кто здесь

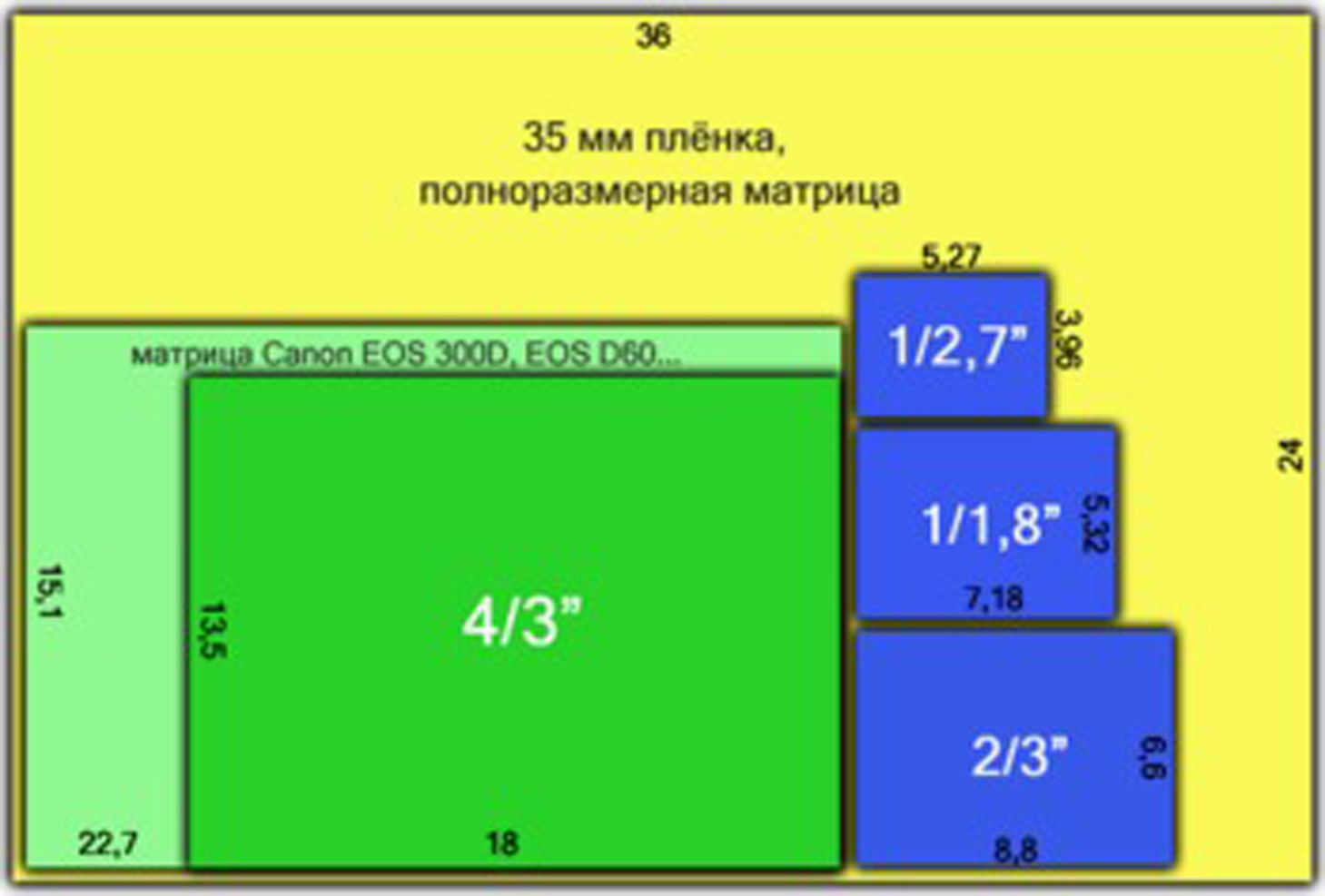

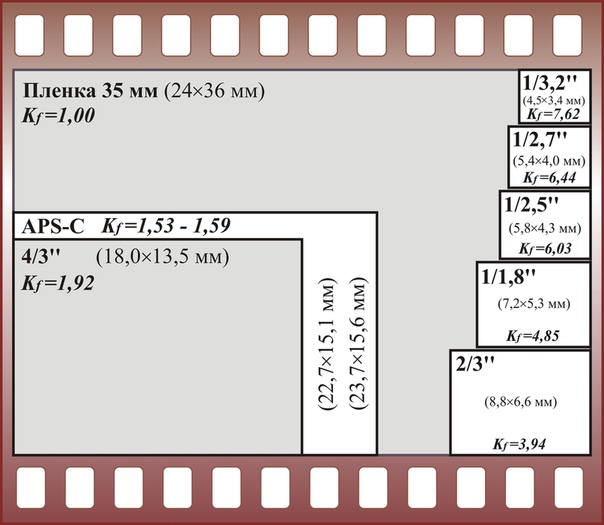

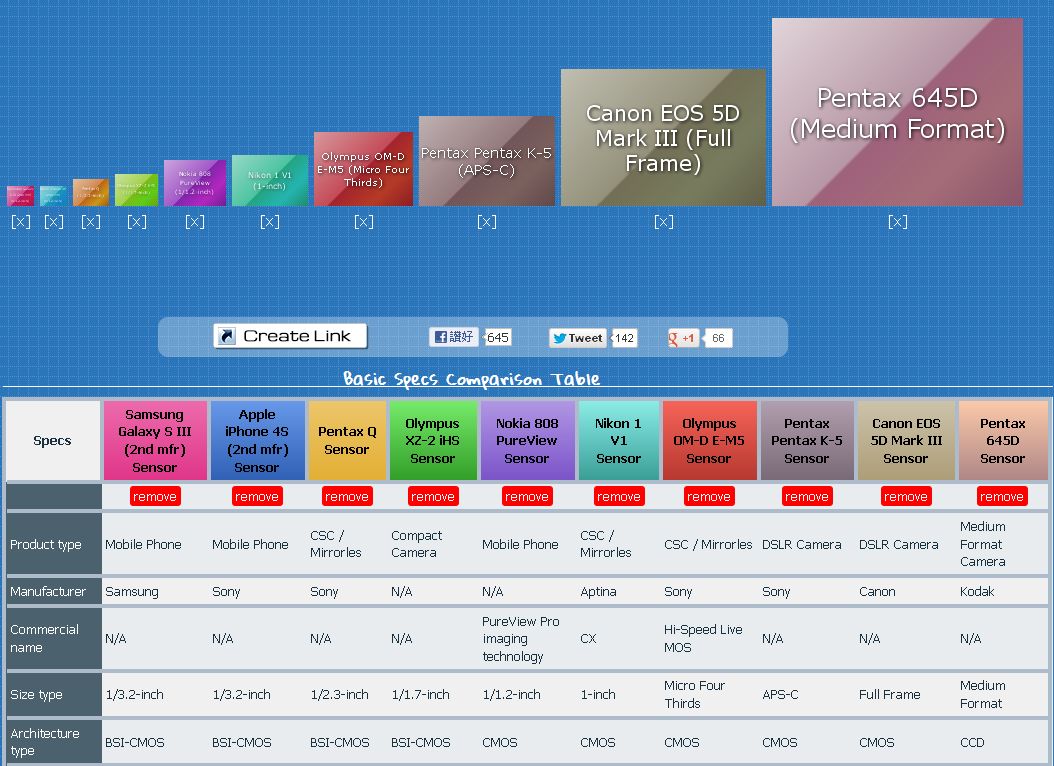

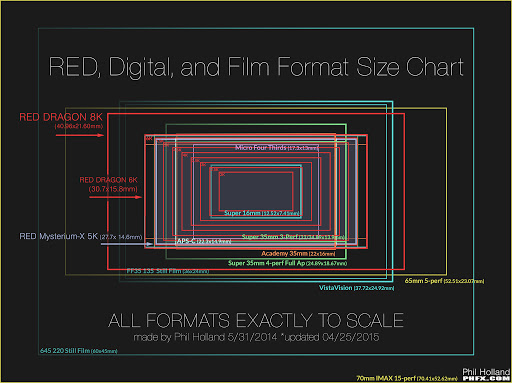

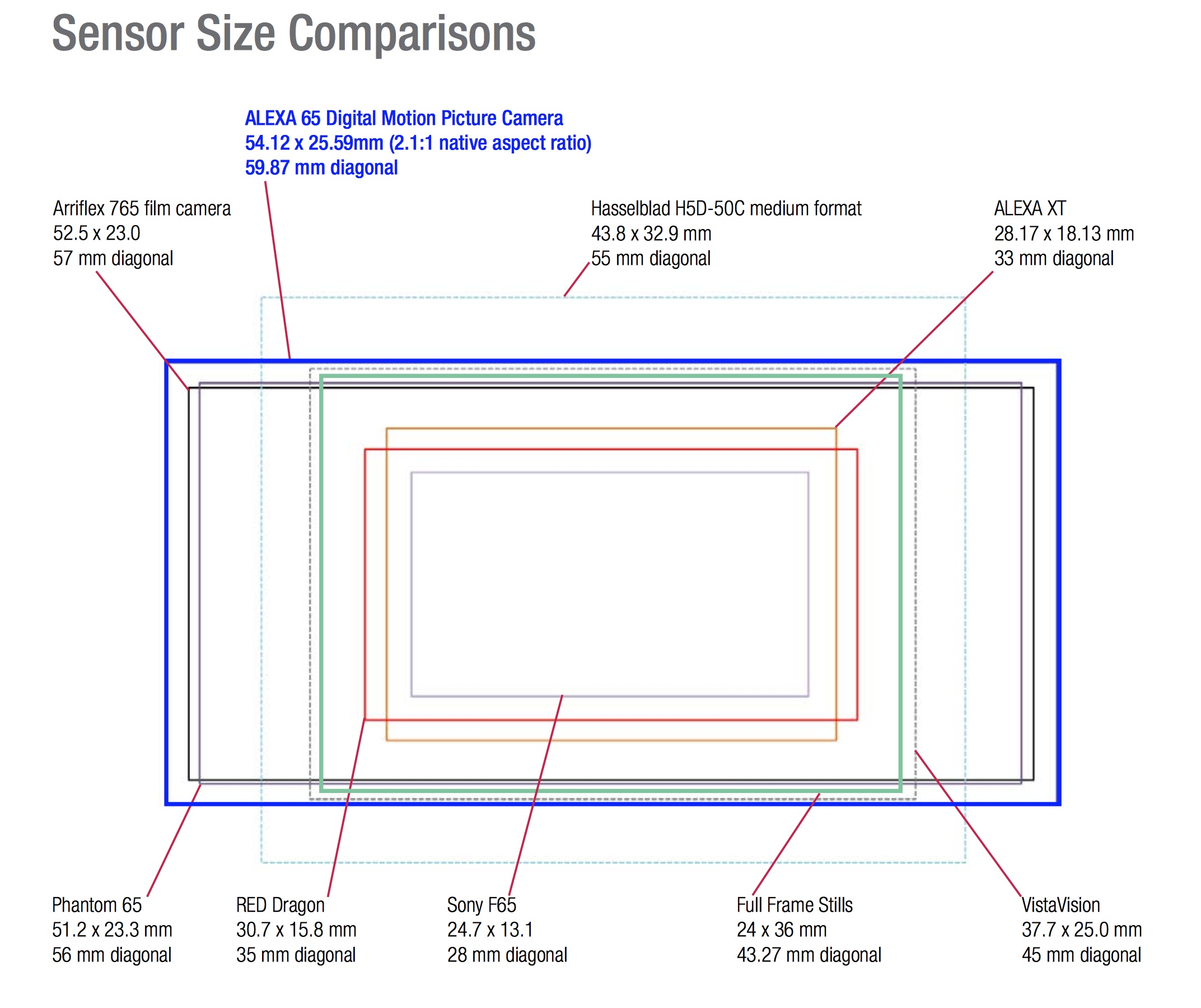

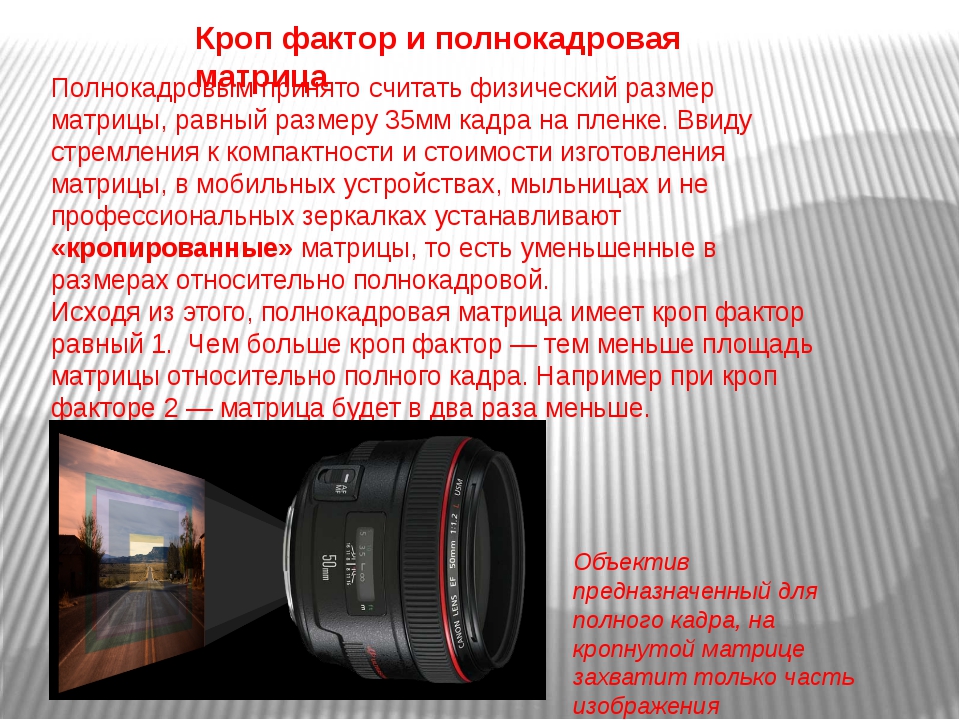

Эту таблицу я сделал уже много лет назад, для наглядного сравнения цифровых фотоаппаратов. В те годы было много путаницы даже с понятием «кропа» и «полного формата», не говоря уже про компактные и среднеформатные аппараты. Скудная информация была разбросана по многочисленным сайтам производителей фототехники, и сравнить камеры наглядно было практически невозможно. Всё это вводило в заблуждение многих фотолюбителей, разжигая яростные споры на профильных форумах.

Чтобы как-то упорядочить ситуацию и привести к одному знаменателю любые камеры — от мыльниц до среднеформатных камер, я решил использовать понятие плотности пикселей — DPI (хотя, возможно, будет правильней сказать ppi). Почему я выбрал именно этот параметр, который раньше нигде не использовался для этого? Просто потому, что имевшаяся в открытом доступе информация, позволяла рассчитывать его идеально точно, без погрешностей. Зная длину и ширину матрицы, а также количество пикселей, я мог без труда, абсолютно точно рассчитать их плотность. В качестве бонуса, понятие плотности пикселей, позволило сравнить матрицу любого размера с разрешением сканов с плёнки (DPI цифрового фотоаппарата и установленное DPI во время сканирования — по сути, одно и то же).

Зная длину и ширину матрицы, а также количество пикселей, я мог без труда, абсолютно точно рассчитать их плотность. В качестве бонуса, понятие плотности пикселей, позволило сравнить матрицу любого размера с разрешением сканов с плёнки (DPI цифрового фотоаппарата и установленное DPI во время сканирования — по сути, одно и то же).

Удобная в использовании, наглядная таблица, позволила двигаться дальше, по пути познания технических характеристик матриц, и, со временем, обросла массой дополнительных «полезностей». Сегодня в таблице собраны самые разные параметры, имеющие отношение к матрицам цифровых фотоаппаратов. Это и размер пикселя, и точный кроп-фактор, и площадь матрицы, и дифракционное ограничение диафрагмы. С помощью этой таблицы можно легко отслеживать тренды развития фототехники, прогнозировать грядущие изменения или просто выбирать камеру.

Разобраться в многочисленных параметрах таблицы сходу не так просто. Помочь фотографу в этом должны специальные статьи, сопровождающие таблицу, раскрывающие её особый смысл.

Приятного чтения!

Часть первая. Увеличивает ли кроп-фактор способность объективов «приближать»?

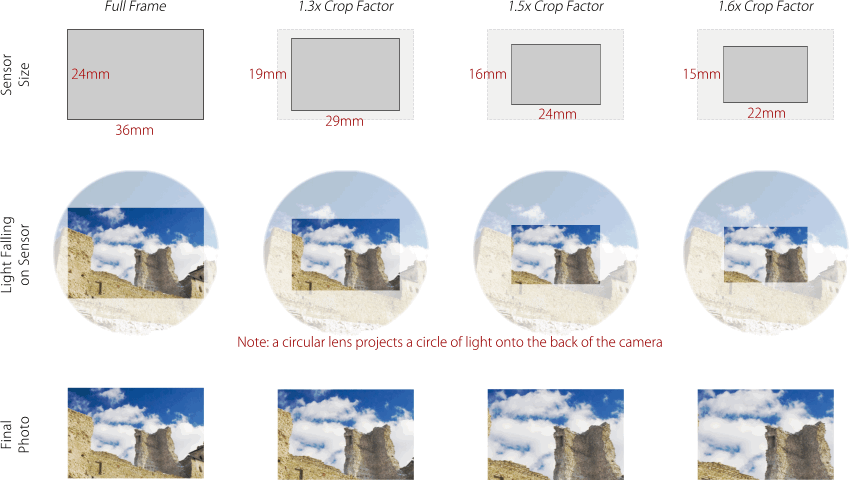

Поскольку я занимаюсь фотографией дикой природы, часто бывает просто невозможно подойти ближе к объекту съёмки (из-за риска испугать животное или птицу). И тут во всесь рост встаёт проблема нехватки фокусного расстояния объективов (говоря простым языком — способности оптики «приближать удалённые объекты»). На заре цифровой фотографии, было крайне распространено мнение, что камеры с «кропнутой» матрицей увеличивают фокусное расстояние объективов в кроп раз. Тут я постараюсь объяснить, почему неправильно так думать.

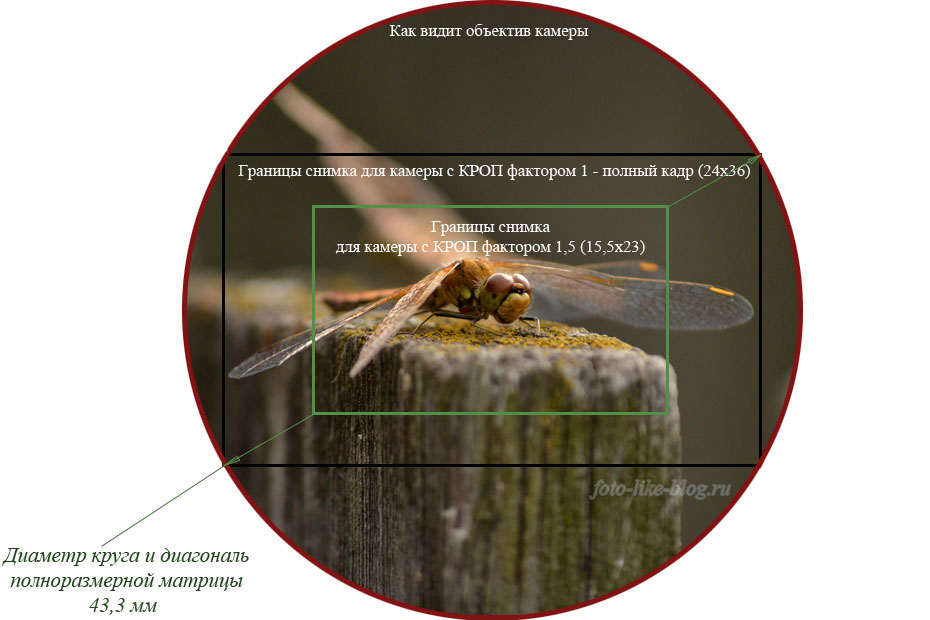

Сейчас у меня есть две камеры. Одна полноформатная — Canon EOS 5D Mark II, вторая с кроп-фактором 1,6х — Canon EOS 20D. Кроп-фактор 1,6, означает, что диагональ матрицы 20D в 1,6 раза меньше, чем диагональ матрицы 5D MarK II. 43mm разделить на 27mm равно 1,6.

С кроп-фактором разобрались. Матрица уменьшилась. Но оптика то осталась прежней. Объектив, например, 300мм подходит как к 20D, так и к 5D Mark II. Что будет, если один и тот же кадр снять на 5D Mk II и на 20D? Самая наглядная и точная метафора — взять большой напечатанный кадр, и вырезать из него середину ножницами. Какая разница, резать матрицу или уже готовый кадр? Вот так:

Что будет, если один и тот же кадр снять на 5D Mk II и на 20D? Самая наглядная и точная метафора — взять большой напечатанный кадр, и вырезать из него середину ножницами. Какая разница, резать матрицу или уже готовый кадр? Вот так:

Конечно, на вырезанном кадре птица выглядит крупнее. Часто, начинающими фотографами, это свойство кропа ошибочно воспринимается как плюс. Но на самом деле, плюсом вовсе не является. Зачем спешить, и «вырезать кадр» до съёмки? А если птица подлетит ближе, или нам захочется вырезать не середину, а край снимка? На полноформатной матрице мы можем резать как угодно, а можем вообще не резать. А вот кроп вариантов уже не оставляет. Вылезшие за край кадра крылья уже не вернуть, и потенциально хороший снимок отправляется в корзину.

примеры основных кроп-факторов: 1.3х, 1.6х и 2х

Спорить, что лучше, кроп или полный формат я тут не стану. Кроп может быть дешевле или быстрее. Тут у каждого своё решение. Вместо ненужных споров, предлагаю ответить на вопрос, какая характеристика камеры может по-настоящему способствовать качественному приближению? И ответ прост — плотность пикселей (столбик dpi в таблице). Для того, чтобы понять, почему это так, давайте рассмотрим ещё один пример из жизни. В этот раз, для удобства, возьмём две полноформатные камеры — 5D и 5D Mark II. Особо подчеркну, что для конечного результата совершенно не важно, полный формат у нас или кроп, тут играет роль только один параметр — плотность пикселей. У 5D это 3101 dpi, у 5D Mark II — 3955 dpi.

Для того, чтобы понять, почему это так, давайте рассмотрим ещё один пример из жизни. В этот раз, для удобства, возьмём две полноформатные камеры — 5D и 5D Mark II. Особо подчеркну, что для конечного результата совершенно не важно, полный формат у нас или кроп, тут играет роль только один параметр — плотность пикселей. У 5D это 3101 dpi, у 5D Mark II — 3955 dpi.

Представьте сафари: яркий солнечный день, низкая чувствительность ISO, отличная оптика. И вдруг мы видим дикого леопарда в 100 метрах от нас. Делаем снимок, и зверь скрывается. 100 метров — это далеко. Для того, чтобы кадр хорошо смотрелся, нам волей-неволей придётся сильно кадрировать, оставив 1/10 от полного кадра (для простоты подсчёта). Математика подсказывает, что кадр с камеры 5D (12мп) после кадрирования будет состоять из 1,2мп (12 разделить на 10), что очень мало и не годится для качественной печати. А вот снимок с 5D MII (21мп) будет состоять из 2,1 мп, что уже значительно лучше! И я ещё раз хочу подчеркнуть — совершенно не важно, кроп у нас, или полный формат. 20D, у которой плотность 3955dpi (как и у 5D Mark II), аналогичный кадр, в тех-же самых условиях, тоже состоял бы из 2,1 мп. Несмотря на то, что матрица там всего 8 мегапикселей. Тут играет роль только плотность пикселей.

20D, у которой плотность 3955dpi (как и у 5D Mark II), аналогичный кадр, в тех-же самых условиях, тоже состоял бы из 2,1 мп. Несмотря на то, что матрица там всего 8 мегапикселей. Тут играет роль только плотность пикселей.

Леопарда снять одновременно с двух камер не представляется возможным, поэтому я попробовал тест попроще, чтобы наглядно показать разницу от плотности пикселей. Два тестовых кадра, были сняты со штатива, с одинакового расстояния, с одинаковой оптики, с одинаковым фокусным расстоянием:

полный кадр выглядел так

при очень сильном приближении становится видна разница

Это не сравнение 450D против 1D Mark III. Это сравнение 3514 dpi против 4888 dpi. В этих условиях, аналогичный результат будет на любой другой паре камер с подобной плотностью пикселей. Просто когда я писал статью, у меня были именно эти две камеры, вот и всё.

Ps:

- Тесты проводились в хороших условиях, и рассматривались под большим увеличением.

В реальной жизни, скорее всего, разница будет заметна ещё меньше. Стоит оно того или нет, решать только вам.

В реальной жизни, скорее всего, разница будет заметна ещё меньше. Стоит оно того или нет, решать только вам. - Разумеется, качество 21 мегапикселя 5D Mark II, в сравнении с 12 мегапикселями 5D, будет заметно не только при сильном кадрировании. Надеюсь, это и так всем понятно.

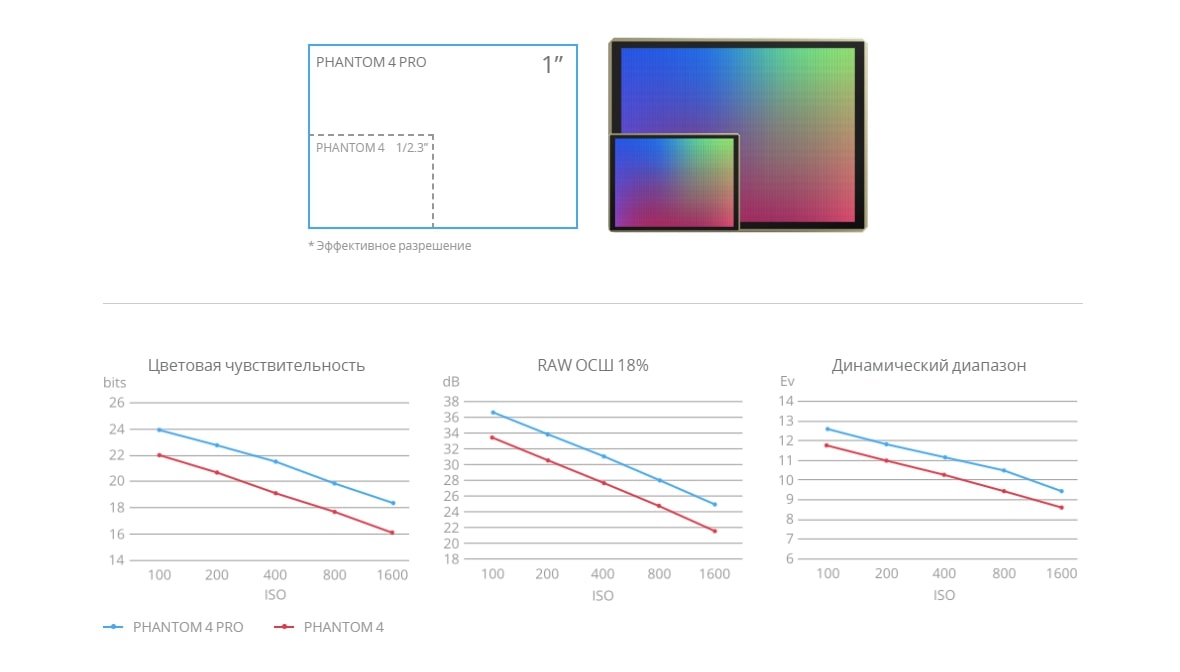

Часть вторая. Меньше пиксель — больше шум

Из первой части можно сделать вывод — давайте наращивать плотность пикселей, что бы картинка была лучше. Но не всё так просто. Чем больше плотность пикселей, тем меньше площадь каждого конкретного пикселя (такой столбик тоже есть в таблице). Чем меньше площадь пикселя, тем меньше фотонов света он улавливает. Фотоны — это полезный сигнал. Чем их меньше, тем хуже соотношение сигнал/шум, тем хуже чувствительность камеры.

Скажу просто — камеры, которые мне приходилось тестировать, с размером пикселя менее 6 микрон, имеют плохую чувствительность и более высокий шум. Это моё мнение, мой опыт. Пока что никаких исключений в этом правиле я не видел. Возможно, когда-нибудь, технологии позволят делать новые камеры более чувствительными, но пока так. Возникает вопрос, что выбрать? Плотность пикселей или чувствительность? Тут всем придётся искать свой собственный ответ. Кому интересно моё мнение, смотрите следующие два абзаца, но… никому его не навязываю. 🙂

Возможно, когда-нибудь, технологии позволят делать новые камеры более чувствительными, но пока так. Возникает вопрос, что выбрать? Плотность пикселей или чувствительность? Тут всем придётся искать свой собственный ответ. Кому интересно моё мнение, смотрите следующие два абзаца, но… никому его не навязываю. 🙂

Я проанализировал свои снимки, за последние несколько лет, размышляя, может ли большая плотность пикселей увеличить качество моих снимков. Результат оказался очень неожиданным: снимков, качество которых можно улучшить за счёт плотности пикселей, оказалось крайне мало. Помимо моих кривых рук, виной тому стали многие естественные факторы — шумы, шевелёнка, качество оптики, «воздух», не точный АФ и пр. Причём, 90% снимков, которые можно было бы улучшить повышенной плотностью пикселей, в улучшении и не нуждались — все они и так обладали достаточным качеством.

Показательно, что большая часть некачественных фотографий страдала из-за недостатка чувствительности. Шевелёнка и шумы мне, как фотографу дикой природы, сейчас мешают гораздо сильнее. 16-25 мегапикселей на полном формате — мой идеал на сегодняшний день.

16-25 мегапикселей на полном формате — мой идеал на сегодняшний день.

Также не стоит забывать про ДД — динамический диапазон, который очень тесно связан с шумами, т.к. они ограничивают его в тенях. Меньше пиксель — меньше и ДД. Выводы тут каждый сам для себя сделает. А тех, кому важнее окажется плотность пикселей, я хочу предупредить об ещё одном коварном враге, который будет вечно подстерегать Вас, и от которого Вам не скрыться. По крайней мере в этой Вселенной. Это дифракция…

Часть третья. Дифракция в фотографии. Теория

Для этой части моей статьи все рисунки взяты из

замечательного учебного пособия про дифракцию:

Tutorials: difraction & photography. Очень рекомендую

его всем, кто хочет глубоко разобраться в этой теме.

В этой части матрица ни причём, а отдуваться всё равно приходится. За физику. Какое отношение имеет дифракция к матрице цифрового фотоаппарата? Никакого. Но давайте рассмотрим, что же мы имеем ввиду под словом дифракция, когда говорим о головной боли фотографов?

Если не вдаваться в подробности, то дифракция — это физическое явление, которое мешает нам сильно закрывать диафрагму, снижая качество получаемого изображения.

Если рассмотреть причины дифракции, то мы увидим, что появляется она при прохождении света через диафрагму. После прохождения диафрагмы, лучи идут уже не столь прямо, как нам хотелось бы, а немного «расслаиваются», расходятся в стороны. В результате каждый лучик образует на поверхности матрицы не просто точку, а «кружок и круги по воде» — дифракционные кольца, или, как это ещё называют диск Эри (по фамилии учёного, английского астронома — George Biddell Airy):

Разумеется, что, в отличие от хорошо сфокусированной точки, подобные диски могут залезть на соседние пиксели, если те расположены достаточно плотно. А когда они лезут на соседние пиксели, мы прощаемся с хорошей резкостью.

Давайте рассмотрим это явление на примере. Зная размер пикселей, мы без труда построим сетку, обозначающую границы пикселей (пунктиром). Далее по формуле мы вычисляем диаметр диска Эри и для упрощения представляем его в виде пятна света. И попробуем наложить диски Эри, характерные для самых распространённых диафрагм, на нашу сетку. Для примера я взял размер пикселя камеры 5D MarkII, а значения диафрагм указаны под каждым рисунком:

Для примера я взял размер пикселя камеры 5D MarkII, а значения диафрагм указаны под каждым рисунком:

Как вы видите, при неизменной сетке пикселей кружок Эри растёт. При f/16 он уже значительно залезает на соседние пиксели, что в реальной жизни будет размывать картинку, не давая нам попиксельной резкости. А при f/22 этот диск занимает почти всю площадь 9 пикселей!

Зная размеры этого кружка, я могу рассчитать максимально закрытую диафрагму, после которой дальнейшее закрытие, будет ухудшать фотографию. Этот параметр мой коллега с the-digital-picture.com называет DLA (diffraction limited aperture), что соответствует русскому термину ДОД (дифракционное ограничение диафрагмы). Однако мои расчёты числового значения этого параметра несколько отличаются от вычислений автора вышеуказанного сайта. Например, в своей формуле он, видимо, каким-то образом учитывает и размер всей матрицы (в частности, при равной плотности пикселей, значения DLA 40D (f/9.3) и 1D MarkIV (f/9.1) различаются). Это, конечно же, не может быть верным, когда мы говорим о дифракции на уровне пикселей. Впрочем, наши результаты не сильно расходятся, так что разницей можно принебречь. К тому же, в силу сочетания очень многих факторов (нечеткость границ диска, сложная структура ячеек матрицы и пр.), невозможно с абсолютной точностью назвать величину DLA, после которой начинает наблюдаться деградация изображения.

Это, конечно же, не может быть верным, когда мы говорим о дифракции на уровне пикселей. Впрочем, наши результаты не сильно расходятся, так что разницей можно принебречь. К тому же, в силу сочетания очень многих факторов (нечеткость границ диска, сложная структура ячеек матрицы и пр.), невозможно с абсолютной точностью назвать величину DLA, после которой начинает наблюдаться деградация изображения.

Итак, давайте посмотрим, как это работает. Для 5D MarkII (как и для 20D), DLA составляет f/10,8, что очень близко к рисунку выше с подписью f/11. В то же время, для Canon 1D (всего 4 mp, — самые крупные ячейки матрицы среди всех камер Canon), этот параметр составляет f/19,1. Давайте закроем диафрагму до f/16, и посмотрим, как будет выглядеть диск Эри, спроецированный на сетку пикселей 1D и на сетку 5D MarkII (или 1Ds MarkIII или 20D):

Как видно из этого примера, что позволено Юпитеру, не позволено быку. При съёмке на 1D мы легко можем закрыть диафрагму до f/16, а на 5D Mark II это приведёт к снижению возможной детализации.

Часть четвёртая. Дифракция в фотографии. Практика

Выше была лишь сухая теория. Она абсолютно верна, но не учитывает того, что оптика очень часто не способна выдать достаточной детализации, на диафрагмах уже DLA. Так как же дело обстоит на практике?

Действительно, оптика не всегда даёт качество, которое позволило бы нам видеть попиксельную резкость. Более того, как мы знаем, качество изображения растёт по мере закрытия диафрагмы. Из-за этого у качественной оптики мы можем заметить ухудшение качества из-за дифракции на диафрагмах близких к DLA, а вот у плохих это может произойти на значительно позже. Однако, если ухудшение наступает на одно или даже два значения диафрагмы уже DLA, это означает, что матрица камеры с этим объективом никогда не получает достаточно детаелй. Т.е. попиксельной резкости там не будет никогда, иначе дифракцию мы бы смогли заметить на уровне числового значения DLA.

Что же мы можем наблюдать на камерах с большой плотностью пикселей? Для примера возьмём новую (на момент написания этих строк) камеру Canon EOS 7D. DLA там составляет f/7,2. Что это значит? Это значит, что 7D сможет выдать попиксельную детализацию только на диафрагмах менее 7,2. Возьмём хорошую оптику и посмотрим на результат. Для этого обратимся за помощью к ресурсу The Digital Picture. Там мы можем найти снимок специальной тестовой таблицы на камеру 7D с использованием хорошей оптики (Canon EF 200mm f/2.0L IS USM). Сравним кадр, сделанный при диафрагме 5,6 и 8. Как мы видим, резкость незначительно ухудшается — теория работает! Теперь сравним 5,6 и 11 — вот тут уже идёт заметное падение резкости, причём не только по центру, но даже в углах!

DLA там составляет f/7,2. Что это значит? Это значит, что 7D сможет выдать попиксельную детализацию только на диафрагмах менее 7,2. Возьмём хорошую оптику и посмотрим на результат. Для этого обратимся за помощью к ресурсу The Digital Picture. Там мы можем найти снимок специальной тестовой таблицы на камеру 7D с использованием хорошей оптики (Canon EF 200mm f/2.0L IS USM). Сравним кадр, сделанный при диафрагме 5,6 и 8. Как мы видим, резкость незначительно ухудшается — теория работает! Теперь сравним 5,6 и 11 — вот тут уже идёт заметное падение резкости, причём не только по центру, но даже в углах!

Весь парадокс камер с высокой плотностью пикселей, что оптике и так сложно передать значительное количество деталей, а передать значительное количество деталей на диафрагмах шире, чем f/8… боюсь это задача лишь для действительно великолепных объективов. Таких, как Canon EF 200mm f/2.0L IS USM ~ за 6000$…

В заключение, для невнимательных читателей, я хочу ещё раз подчеркнуть, что дифракция не является параметром матрицы, искажает изображение до матрицы и не зависит от марки камеры (а если и зависит, разница минимальна и я её не учитываю).

Благодарю Дмитрия (Доктор Ктулху) за помощь, оказанную в процессе редактирования текста статьи.

Таблица характеристик матриц цифровых фотоаппаратов

| Модель | Произв | Тип | Mp* | Кроп-фактор | Размер пикселя (микрон) | Площадь (мм2 ) | Размер матрицы (мм) | Размер матрицы (пикселей) | DPI | DLA** | FF*** (mp) |

| C a n o n | |||||||||||

| 1D | Kodak | CCD | 4,1 | 1.3 х | 11,6 µm | 548,2 | 28,7 x 19,1 | 2464 x 1648 | 2181 | f/19,1 | 6,4 |

| D30 | Canon | CMOS | 3,1 | 1. 6 х 6 х | 10,5 µm | 342,8 | 22,7 x 15,1 | 2160 x 1440 | 2417 | f/17,6 | 7,8 |

| 1Ds | Canon | CMOS | 11,0 | 1.0 х | 8,8 µm | 852 | 35,8 x 23,8 | 4064 x 2704 | 2883 | f/14,8 | 11,1 |

| 1D Mark II | Canon | CMOS | 8,2 | 1.3 х | 8,2 µm | 548,2 | 28,7 x 19,1 | 3504 x 2336 | 3101 | f/13,8 | 12,9 |

| 5D | Canon | CMOS | 12,7 | 1.0 х | 8,2 µm | 852 | 35,8 x 23,9 | 4368 x 2912 | 3101 | f/13,8 | 12,9 |

| 300D/D60/10D | Canon | CMOS | 6,3 | 1. 6 х 6 х | 7,4 µm | 342,8 | 22,7 x 15,1 | 3072 x 2048 | 3400 | f/12,4 | 15,5 |

| 1Ds Mark II | Canon | CMOS | 16,6 | 1.0 х | 7,2 µm | 864 | ~ 36 x 24 | 4992 x 3328 | 3514 | f/12,1 | 16,5 |

| 1D Mark III | Canon | CMOS | 10,1 | 1.3 х | 7,2 µm | 525,5 | 28,1 x 18,7 | 3888 x 2592 | 3514 | f/12,1 | 16,5 |

| 1D x | Canon | CMOS | 17,9 | 1.0 х | 6,9 µm | 864 | 36 x 24 | 5184 x 3456 | 3657 | f/11,7 | 17,9 |

| 350D/20D/30D | Canon | CMOS | 8,2 | 1. 6 х 6 х | 6,4 µm | 337,5 | 22,5 x 15,0 | 3504 x 2336 | 3955 | f/10,8 | 20,9 |

| 5D II / 1Ds III | Canon | CMOS | 21,0 | 1.0 х | 6,4 µm | 864 | ~ 36 x 24 | 5616 x 3744 | 3955 | f/10,8 | 20,9 |

| 5D III | Canon | CMOS | 22,1 | 1.0 х | 6,25 µm | 864 | 36 x 24 | 5760 x 3840 | 4064 | f/10,6 | 22,1 |

| 1000D/400D/40D | Canon | CMOS | 10,1 | 1.6 х | 5,7 µm | 328,6 | 22,2 x 14,8 | 3888 x 2592 | 4455 | f/9,6 | 26,6 |

| Canon EOS 1D Mark IV | Canon | CMOS | 16,1 | 1. 3 х 3 х | 5,7 µm | 518,9 | 27,9 x 18,6 | 4896 x 3264 | 4455 | f/9,6 | 26,6 |

| Canon EOS 450D | Canon | CMOS | 12,2 | 1.6 х | 5,2 µm | 328,6 | 22,2 x 14,8 | 4272 x 2848 | 4888 | f/8,7 | 32,0 |

| 500D, 50D | Canon | CMOS | 15,1 | 1.6 х | 4,7 µm | 332,3 | 22,3 x 14,9 | 4752 x 3168 | 5413 | f/7,9 | 39,2 |

| 7D / 60D / 600D | Canon | CMOS | 17,9 | 1.6 х | 4,3 µm | 332,3 | 22,3 x 14,9 | 5184 x 3456 | 5905 | f/7,2 | 46,7 |

| 7D Mark II | Canon | CMOS | 19. 96 96 | 1.6 х | 4,1 µm | 336 | ~ 22,4 x 15,0 (?) | 5472 x 3648 | ~ 6177 | f/6.9 | 50,3 |

| 5Ds (r) | Canon | CMOS | 50,3 | 1.0 х | 4,1 µm | 864 | 36 x 24 | 8688 x 5792 | 6130 | f/6.9 | 50,3 |

| N i k o n | |||||||||||

| D1/D1H | Sony | CCD | 2,6 | 1.5 х | 11,9 µm | 367,4 | 23,7 x 15,5 | 2000 x 1312 | 2143 | f/20 | 6,2 |

| D2H | Nikon | JFET | 4,0 | 1.5 х | 9,6 µm | 367,4 | 23,7 x 15,5 | 2464 x 1632 | 2641 | f/16,1 | 9,3 |

| D1X**** | Sony | CCD | 5,3 | 1. 5 х 5 х | 5,9/11,9 | 369,7 | 23,7 x 15,6 | 4028 x 1324 | — | — | — |

| D700/D3/D3s | ? | CMOS | 12.1 | 1.0 х | 8,4 µm | 860,4 | 36,0 x 23,9 | 4256 x 2832 | 3003 | f/14,1 | 12,2 |

| D4 | ? | CMOS | 16,2 | 1.0 х | 7,3 µm | 860,4 | 36,0 x 23,9 | 4928 x 3280 | 3476 | f/12,4 | 16,2 |

| D40/D50/D70/D100 | Sony | CCD | 6,0 | 1.5 х | 7,8 µm | 367,4 | 23,7 x 15,5 | 3008 x 2000 | 3237 | f/13,1 | 14,0 |

| D3000/D40x/D60/D80/D200 | Sony | CCD | 10,0 | 1. 5 х 5 х | 6,1 µm | 372,9 | 23,6 x 15,8 | 3872 x 2592 | 4167 | f/10,3 | 23,4 |

| D3X | ? | CMOS | 24,4 | 1.0 х | 5,9 µm | 861,6 | 35,9 x 24 | 6048 x 4032 | 4279 | f/9,9 | 24,4 |

| D5000 / D90 | Sony | CMOS | 12.2 | 1.5 х | 5,4 µm | 369,7 | 23,7 x 15,6 | 4288 x 2848 | 4637 | f/9 | 28,8 |

| D300 (s) / D2X (s) | Sony | CMOS | 12.2 | 1.5 х | 5,4 µm | 369,7 | 23,7 x 15,6 | 4288 x 2848 | 4637 | f/9 | 28,8 |

| D800 (e) | ? | CMOS | 36,2 | 1. 0 х 0 х | 4,9 µm | 861,6 | 35,9 x 24 | 7360 x 4912 | 5207 | f/8,2 | 36,3 |

| D7000/5100 | Sony | CMOS | 16.1 | 1.5 х | 4,8 µm | 370,5 | 23,6 x 15,7 | 4928 x 3264 | 5303 | f/8,1 | 37,4 |

| S o n y | |||||||||||

| A 100/200/230/300/330 | Sony | CCD | 10.0 | 1.5 х | 6,1 µm | 372,9 | 23,6 x 15,8 | 3872 x 2592 | 4167 | f/10,2 | 23,3 |

| A900 / A850 | Sony | CMOS | 24,4 | 1.0 х | 5,9 µm | 861,6 | 35,9 x 24 | 6048 x 4032 | 4279 | f/9,9 | 24,4 |

| A500 | Sony | CMOS | 12. 2 2 | 1.5 х | 5,7 µm | 366,6 | 23,5 x 15,6 | 4272 x 2848 | 4617 | f/9,6 | 28,6 |

| A700 | Sony | CMOS | 12.2 | 1.5 х | 5,5 µm | 368,2 | 23,5 x 15,6 | 4288 x 2856 | 4635 | f/9,2 | 28,8 |

| A350/A380 | Sony | CCD | 14.0 | 1.5 х | 5,1 µm | 369 | 23,5 x 15,7 | 4592 x 3056 | 4963 | f/8,6 | 33,0 |

| Sony A550 | Sony | CMOS | 14.0 | 1.5 х | 5,1 µm | 365 | 23,4 x 15,6 | 4592 x 3056 | 4984 | f/8,6 | 33,3 |

| SLT-A57/35/55/A580 | Sony | CMOS | 16,0 | 1. 5 х 5 х | 4,8 µm | 366,6 | 23,5 x 15,6 | 4912 x 3264 | 5309 | f/8,1 | 37,7 |

| SLT-A77 / A65 / NEX-7 | Sony | CMOS | 24,0 | 1.5 х | 3,9 µm | 366,6 | 23,5 x 15,6 | 6000 x 4000 | 6485 | f/6,5 | 54 |

| F u j i f i l m***** | |||||||||||

| S2 Pro | Fujifilm | CCD | 6,1 | 1.6 х | 7,6 µm | 356,5 | 23 x 15.5 | 3024 x 2016 | 3340 | f/12,8 | 14,9 |

| S3/S5 Pro | Fujifilm | CCD | 6,1 | 1.6 х | 7,6 µm | 356,5 | 23 x 15.5 | 3024 x 2016 | 3340 | f/12,8 | 14,9 |

| P e n t a x | |||||||||||

| K100D (Super) /K110D | Sony | CCD | 6,0 | 1. 5 х 5 х | 7,8 µm | 368,95 | 23,5 x 15,7 | 3008 x 2008 | 3251 | f/13,1 | 14,2 |

| K10D/K200D/K2000 | Sony | CCD | 10,0 | 1.5 х | 6,1 µm | 369 | 23,5 x 15,7 | 3872 x 2592 | 4185 | f/10,3 | 23,6 |

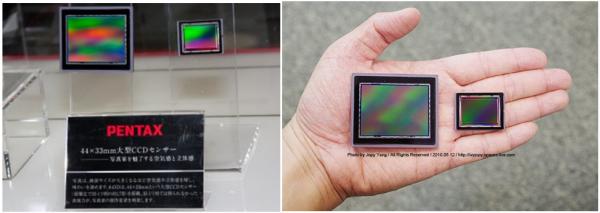

| 645D | Kodak | CCD | 39,5 | 0.7 х | 6,1 µm | 1452 | 44 x 33 | 7264 x 5440 | 4193 | f/10,2 | 24,5 |

| K-r | ? | CMOS | 12.2 | 1.5 х | 5,5 µm | 372,9 | 23,6 x 15,8 | 4288 x 2848 | 4615 | f/9,3 | 28,3 |

| K20D/K-7 | Samsung | CMOS | 14. 5 5 | 1.5 х | 5,0 µm | 365 | 23,4 x 15,6 | 4672 x 3104 | 5071 | f/8,4 | 34,5 |

| K-5 | Sony | CMOS | 16.1 | 1.5 х | 4,8 µm | 370,5 | 23,6 x 15,7 | 4928 x 3264 | 5303 | f/8,1 | 37,4 |

| S i g m a****** | |||||||||||

| SD14/SD15/DP1/DP2 | Foveon | CMOS | 4,7 | 1.7 х | 7,8 µm | 285,7 | 20,7 x 13,8 | 2640 x 1760 | 3239 | f/13,1 | 14,1 |

| SD1 (m) | Foveon | CMOS | 15,4 | 1.5 х | 5 µm | 384 | 24 x 16 | 4800 x 3200 | 5080 | f/8,5 | 34,6 |

| S a m s u n g | |||||||||||

| GX-20 | Samsung | CMOS | 14. 6 6 | 1.5 х | 5,0 µm | 365 | 23,4 x 15,6 | 4688 x 3120 | 5089 | f/8,4 | 34,6 |

| NV40 | ? | CCD | 10,1 | 6,0 x | 1,7 µm | 28,2 | 6,13 x 4,60 | 3648 x 2736 | 15116 | f/2,9 | 306 |

| O l y m p u s | |||||||||||

| E400/410/420/450 | Matsushita | NMOS | 9.98 | 2.0 х | 4,7 µm | 225 | 17,3 x 13,0 | 3648 x 2736 | 5356 | f/7,9 | 38,4 |

| E510/520/E3 | Matsushita | NMOS | 9.98 | 2.0 х | 4,7 µm | 225 | 17,3 x 13,0 | 3648 x 2736 | 5356 | f/7,9 | 38,4 |

| E620/E30/E5 | Matsushita | NMOS | 12. 2 2 | 2.0 х | 4,3 µm | 225 | 17,3 x 13,0 | 4032 x 3024 | 5919 | f/7,3 | 48,7 |

| E-M5 | Matsushita | NMOS | 15.9 | 2.0 х | 3,7 µm | 225 | 17,3 x 13,0 | 4608 x 3456 | 6765 | f/6,3 | 63,7 |

| L e i c a | |||||||||||

| M8 | Kodak | CCD | 10 | 1.3 x | 6,8 µm | 479,7 | 26,8 x 17,9 | 3936 x 2630 | 3731 | f/11,4 | 18,1 |

| M9 | Kodak | CCD | 18,1 | 1.0 x | 6,8 µm | 864 | 36 x 24 | 5212 x 3472 | 3731 | f/11,4 | 18,1 |

| S2 | Kodak | CCD | 37. 5 5 | 0,8 x | 6,0 µm | 1350 | 45 x 30 | 7500 x 5000 | 4230 | f/10 | 22,4 |

| H a s s e l b l a d | |||||||||||

| h4DII-31 | Kodak | CCD | 31,6 | 0,8 x | 6,8 µm | 1463 | 44,2 x 33,1 | 6496 x 4872 | 3731 | f/11,4 | 18,1 |

| h4DII-39 | Kodak | CCD | 39,0 | 0,7 x | 6,8 µm | 1807 | 49,1 x 36,8 | 7212 x 5412 | 3731 | f/11,4 | 18,1 |

| h4DII-50 | Kodak | CCD | 50,1 | 0,7 x | 6,0 µm | 1807 | 49,1 x 36,8 | 8176 x 6132 | 4230 | f/10 | 22,4 |

| P h o n e s | |||||||||||

| iPhone 3Gs | OV3650 | CMOS | 3,1 | 9. 73 x 73 x | 1,75 µm | 9,8 | 3,63 x 2,71 | 2048 x 1536 | 14343 | f/2,95 | 275 |

| iPhone 4 | OV5650 | CMOS | 5,0 | 7,64 x | 1,75 µm | 15,7 | 4,59 x 3,42 | 2592 x 1936 | 14343 | f/2,95 | 275 |

| iPhone 4s | OmniVision | CMOS | 8,0 | 7,64 x | 1,4 µm | 15,7 | 4,59 x 3,42 | 3264 x 2448 | 18100 | f/2,37 | 438,7 |

| Nokia 808 | ? | CMOS | 41,4 | 3,5 x | 1,4 µm | 81 | 10,8 x 7,5 | 7728 x 5368 | 18100 | f/2,37 | 438,7 |

В эту таблицу я вложил много сил и своего времени, её копирование запрещено (с) VladimirMedvedev. com

com

Примечания:

1 Mp — количество мегапикселей в фотографии

2 DLA (diffraction limited aperture) — ДОД (дифракционное ограничение диафрагмы). Самая узкая диафрагма при которой возможна попиксельная резксть (подробнее см раздел Дифракиция, перед таблицей).

3 36х24 mp — показывает предполагаемое количество пикселей на полноформатной матрице, сделанной по технологии рассматриваемой камеры. Т.е., например, если сделать полноформатную матрицу на основе Canon 50D, то она будет на 39,2 mp.

4 Пиксели Nikon D1x прямоугольные. Реальные 5 mp, получаемые с матрицы растягивались в 10 mp фотографию. Рассчитывать dpi и dla для такой техники смысла нет.

5 Fujifilm — Подсчитывая dpi сенсора у камер Fujifilm с нестандартной матрицей (с ячейками двух типов), учитывались только основные пиксели. Из-за структуры матрицы, было бы не правильно считать и основные и дополнительные пиксели. Основные пиксели занимают практически весь полезный объём, а маленькие, дополнительные, — лишь небольшие ячейки между ними (для более подробной информации смотрите официальный сайт Fujifilm).

6 Sigma — Матрицы Foveon, которые используются в камерах компании Sigma, состоят из трёх слоёв (RGB) и, в отличае от других камер, каждый пиксель на фотографии формируется из трёх пикселей матрицы. Это происходит потому, что пиксели расположены один над одним и не несут дополнительной информации о яркости (только о цвете). Именно поэтому, при матрице в ~ 14 mp, фотографии получаются всего 4 mp. Плотность пикслов рассчитывается для одного слоя.

PS Не могу не отметить, что на самом деле, фотоприёмник занимает далеко не всю площадь пикселя, некоторое место приходится уделять также и, так называемой, обвязке. Для того, чтобы увеличить полезную площадь, производители создают специальные собирающие микро-линзы на матрице:

Чем с большей площади собирают свет микролинзы, тем более эффективной должна быть, в теории, работа матрицы, и тем меньше должно быть шумов. Но это пока только в теории…

CCD или CMOS? Что лучше?

В рубрику «Видеонаблюдение (CCTV)» | К списку рубрик | К списку авторов | К списку публикаций

Сенсор изображения является важнейшим элементом любой видеокамеры. Сегодня практически во всех камерах используются датчики изображения CCD или CMOS. Оба типа датчика выполняют задачу преобразования изображения, построенного на сенсоре объективом, в электрический сигнал. Однако вопрос, какой датчик лучше, до сих пор остается открытым

Сегодня практически во всех камерах используются датчики изображения CCD или CMOS. Оба типа датчика выполняют задачу преобразования изображения, построенного на сенсоре объективом, в электрический сигнал. Однако вопрос, какой датчик лучше, до сих пор остается открытым

Н.И. Чура

Технический консультант

ООО «Микровидео Группа»

CCD является аналоговым датчиком, несмотря на дискретность светочувствительной структуры. Когда свет попадает на матрицу, в каждом пикселе накапливается заряд или пакет электронов, преобразуемый при считывании на нагрузке в напряжение видеосигнала, пропорциональное освещенности пикселей. Минимальное количество промежуточных переходов этого заряда и отсутствие активных устройств обеспечивают высокую идентичность чувствительных элементов CCD.

CMOS-матрица является цифровым устройством с активными чувствительными элементами (Active Pixel Sensor). С каждым пикселем работает свой усилитель, преобразующий заряд чувствительного элемента в напряжение. Это дает возможность практически индивидуально управлять каждым пикселем.

Это дает возможность практически индивидуально управлять каждым пикселем.

Эволюция CCD

С момента изобретения CCD лабораторией Белла (Bell Laboratories, или Bell Labs) в 1969 г. размеры сенсора изображения непрерывно уменьшались. Одновременно увеличивалось число чувствительных элементов. Это естественно вело к уменьшению размеров единичного чувствительного элемента (пикселя), а соответственно и его чувствительности. Например, с 1987 г. эти размеры сократились в 100 раз. Но благодаря новым технологиям чувствительность одного элемента (а следовательно, и всей матрицы) даже увеличилась.

Что позволило доминировать

С самого начала CCD стали доминирующими сенсорами, поскольку обеспечивали лучшее качество изображения, меньший шум, более высокую чувствительность и большую равномерность параметров пикселей. Основные усилия по совершенствованию технологии были направлены на улучшение характеристик CCD.

Как растет чувствительность

По сравнению с популярной матрицей Sony HAD стандартного разрешения (500х582) конца 1990-х гг. (ICX055) чувствительность моделей более совершенной технологии Super HAD выросла почти в 3 раза (ICX405) и Ex-view HAD – в 4 раза (ICX255). Причем для черно-белого и цветного варианта.

(ICX055) чувствительность моделей более совершенной технологии Super HAD выросла почти в 3 раза (ICX405) и Ex-view HAD – в 4 раза (ICX255). Причем для черно-белого и цветного варианта.

Для матриц высокого разрешения (752х582) успехи несколько менее впечатляющие, но если сопоставлять модели цветного изображения Super HAD с самыми современными технологиями Ex-view HAD II и Super HAD II, то рост чувствительности составит в 2,5 и 2,4 раза соответственно. И это несмотря на уменьшение размеров пикселя почти на 30%, поскольку речь идет о матрицах самого современного формата 960H с увеличенным количеством пикселей до 976х582 для стандарта PAL. Для обработки такого сигнала Sony предлагает ряд сигнальных процессоров Effio.

Добавилась ИК-составляющая

Одним из эффективных методов роста интегральной чувствительности является расширение спектральных характеристик чувствительности в область инфракрасного диапазона. Это особенно характерно для матрицы Ex-view. Добавление ИК-составляющей несколько искажает передачу относительной яркости цветов, но для черно-белого варианта это не критично. Единственная проблема возникает с цветопередачей в камерах «день/ночь» с постоянной ИК-чувствительностью, то есть без механического ИК-фильтра.

Добавление ИК-составляющей несколько искажает передачу относительной яркости цветов, но для черно-белого варианта это не критично. Единственная проблема возникает с цветопередачей в камерах «день/ночь» с постоянной ИК-чувствительностью, то есть без механического ИК-фильтра.

Развитие этой технологии в моделях Ex-view HAD II (ICX658AKA) в сравнении с предыдущим вариантом (ICX258AK) обеспечивает рост интегральной чувствительности всего на 0,8 дБ (с 1100 до 1200 мВ) с одновременным увеличением чувствительности на длине волны 950 нм на 4,5 дБ. На рис. 1 приведены характеристики спектральной чувствительности этих матриц, а на рис. 2 – отношение их интегральной чувствительности.

Оптические инновации

Другим методом роста чувствительности CCD являются увеличение эффективности пиксельных микролинз, светочувствительной области и оптимизация цветовых фильтров. На рис. 3 представлено устройство матриц Super HAD и Super HAD II, показывающее увеличение площади линзы и светочувствительной области последней модификации.

Дополнительно в матрицах Super HAD II значительно увеличено пропускание светофильтров и их устойчивость к выцветанию. Кроме того, расширено пропускание в коротковолновой области спектра (голубой), что улучшило цветопередачу и баланс белого.

На рис. 4 представлены спектральные характеристики чувствительности матриц Sony 1/3″ Super HAD (ICX229AK) и Super HAD II (ICX649AKA).

CCD: уникальная чувствительность

В совокупности перечисленных мер удалось добиться значительных результатов по улучшению характеристик CCD.

Сравнить характеристики современных моделей с более ранними вариантами не представляется возможным, поскольку тогда не производились цветные матрицы широкого применения даже типового высокого разрешения. В свою очередь, сейчас не производятся черно-белые матрицы стандартного разрешения по новейшим технологиям Ex-view HAD II и Super HAD II.

В любом случае по чувствительности CCD до сих пор являются пока недостижимым ориентиром для CMOS, поэтому они все еще широко

используются за исключением мегапиксельных вариантов, которые очень дорого стоят и применяются в основном для специальных задач.

CMOS: достоинства и недостатки

Сенсоры CMOS были изобретены в конце 1970-х гг., но их производство удалось начать только в 1990-е по причине технологических проблем. И сразу наметились их основные достоинства и недостатки, которые и сейчас остаются актуальными.

К достоинствам можно отнести большую интеграцию и экономичность сенсора, более широкий динамический диапазон, простоту производства и меньшую стоимость, особенно мегапиксельных вариантов.

С другой стороны, CMOS-сенсоры обладают меньшей чувствительностью, обусловленной, при прочих равных условиях, большими потерями в фильтрах структуры RGB, меньшей полезной площадью светочувствительного элемента. В результате множества переходных элементов, включая усилители в тракте каждого пикселя, обеспечить равномерность параметров всех чувствительных элементов значительно сложнее в сравнении с CCD. Но совершенствование технологий позволило приблизить чувствительность CMOS к лучшим образцам CCD, особенно в мегапиксельных вариантах.

Ранние сторонники CMOS утверждали, что эти структуры будут гораздо дешевле, потому что могут быть произведены на том же оборудовании и по тем же технологиям, что и микросхемы памяти и логики. Во многом данное предположение подтвердилось, но не полностью, поскольку совершенствование технологии привело к практически идентичному по сложности производственному процессу, как и для CCD.

С расширением круга потребителей за рамки стандартного телевидения разрешение матриц стало непрерывно расти. Это бытовые видеокамеры, электронные фотоаппараты и камеры, встроенные в средства коммуникации. Кстати, для мобильных устройств вопрос экономичности довольно важный, и здесь у CMOS-сенсора нет конкурентов. Например, с середины 1990-х гг. разрешение матриц ежегодно вырастало на 1–2 млн элементов и теперь достигает 10–12 Мпкс. Причем спрос на CMOS-сенсоры стал доминирующим и сегодня превышает 100 млн единиц.

CMOS: улучшение чувствительности

Первые образцы камер наблюдения конца 1990-х – начала 2000-х с CMOS-матрицами имели разрешение 352х288 пкс и чувствительность даже для черно-белого варианта около 1 лк. Цветные варианты уже стандартного разрешения отличались чувствительностью около 7–10 лк.

Цветные варианты уже стандартного разрешения отличались чувствительностью около 7–10 лк.

Что предлагают поставщики

В настоящее время чувствительность CMOS-матриц, безусловно, выросла, но не превышает для типовых вариантов цветного изображения величины порядка нескольких люксов при разумных величинах F числа объектива (1,2– 1,4). Это подтверждают данные технических характеристик брендов IP-видеонаблюдения, в которых применяются CMOS-матрицы с прогрессивной разверткой. Те производители, которые заявляют чувствительность около десятых долей люкса, обычно уточняют, что это данные для меньшей частоты кадров, режима накопления или по крайней мере включенной и достаточно глубокой АРУ (AGC). Причем у некоторых производителей IP-камер максимальная АРУ достигает умопомрачительной величины –120 дБ (1 млн раз). Можно надеяться, что чувствительность для этого случая в представлении производителей предполагает пристойное отношение «сигнал/шум», позволяющее наблюдать не один только «снег» на экране.

Инновации улучшают качество видео

В стремлении улучшить характеристики CMOS-матриц компания Sony предложила ряд новых технологий, обеспечивающих практическое сравнение CMOS-матриц с CCD по чувствительности, отношению «сигнал/шум» в мегапиксельных вариантах.

Новая технология производства матриц Exmor основана на изменении направления падения светового потока на матрицу. В типовой архитектуре свет падает на фронтальную поверхность кремниевой пластины через и мимо проводников схемы матрицы. Свет рассеивается и перекрывается этими элементами. В новой модификации свет поступает на тыльную сторону кремниевой пластины. Это привело к существенному росту чувствительности и снижению шума CMOS-матрицы. На рис. 5 поясняется различие структур типовой матрицы и матрицы Exmor, показанных в разрезе.

На фото 1 приведены изображения тестового

объекта, полученные при освещенности 100 лк (F4.0 и 1/30 с) камерой с CCD (фронтальное освещение) и CMOS Exmor, имеющих одинаковый формат и разрешение 10 Мпкс. Очевидно, что изображение камеры с CMOS по крайней мере не хуже изображения с CCD.

Очевидно, что изображение камеры с CMOS по крайней мере не хуже изображения с CCD.

Другим способом улучшения чувствительности CMOS-сенсоров является отказ от прямоугольного расположения пикселей с построчным сдвигом красного и синего элементов. При этом в построении одного элемента разрешения используются по два зеленых пикселя – синий и красный из разных строк. Взамен предлагается диагональное расположение элементов с использованием шести соседних зеленых элементов для построения одного элемента разрешения. Такая технология получила название ClearVid CMOS. Для обработки предполагается более мощный сигнальный процессор изображений. Различие структур расположения цветных элементов иллюстрируются рис. 6.

Считывание информации осуществляется быстродействующим параллельным аналого-цифровым преобразователем. При этом частота кадров прогрессивной развертки может достигать 180 и даже 240 кадр/с. При параллельном съеме информации устраняется диагональный сдвиг кадра, привычный для CMOS-камер с последовательным экспонированием и считыванием сигнала, так называемый эффект Rolling Shutter – когда полностью отсутствует характерный смаз быстро движущихся объектов.

На фото 2 приведены изображения вращающегося вентилятора, полученные CMOS-камерой с частотой кадров 45 и 180 кадр/с.

Полноценная конкуренция

В качестве примеров мы приводили технологии Sony. Естественно, CMOS-матрицы, как и CCD, производят и другие компании, хотя не в таких масштабах и не столь известные. В любом случае все так или иначе идут примерно одним путем и используют похожие технические решения.

В частности, известная технология матриц Panasonic Live-MOS также существенно улучшает характеристики CMOS-матриц и, естественно, похожими методами. В матрицах Panasonic уменьшено расстояние от фотодиода до микролинзы. Упрощена передача сигналов с поверхности фотодиода. Уменьшено количество управляющих сигналов с 3 (стандартные CMOS) до 2 (как в CCD), что увеличило фоточувствительную область пикселя. Применен малошумящий усилитель фотодиода. Используется более тонкая структура слоя датчиков. Сниженное напряжение питания уменьшает шум и нагрев матрицы.

Можно констатировать, что мегапиксельные матрицы CMOS уже могут успешно конкурировать с CCD не только по цене, но и по таким проблемным для этой технологии характеристикам, как чувствительность и уровень шума. Однако в традиционном CCTV телевизионных форматов CCD-матрицы остаются пока вне конкуренции.

Опубликовано: Журнал «Системы безопасности» #5, 2011

Посещений: 92566

Автор

| |||

В рубрику «Видеонаблюдение (CCTV)» | К списку рубрик | К списку авторов | К списку публикаций

Матрицы фотоаппаратов Nikon

© 2017 Vasili-photo. com

com

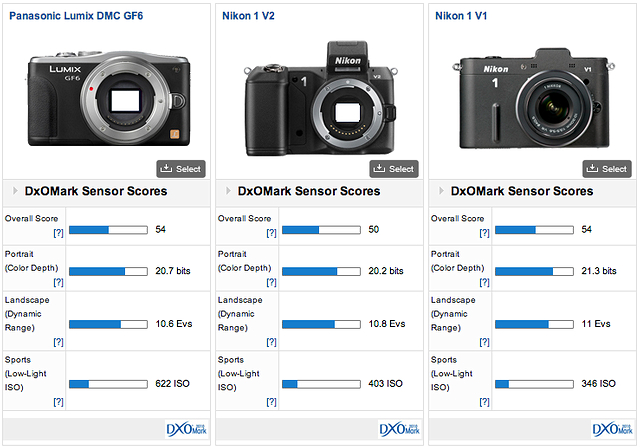

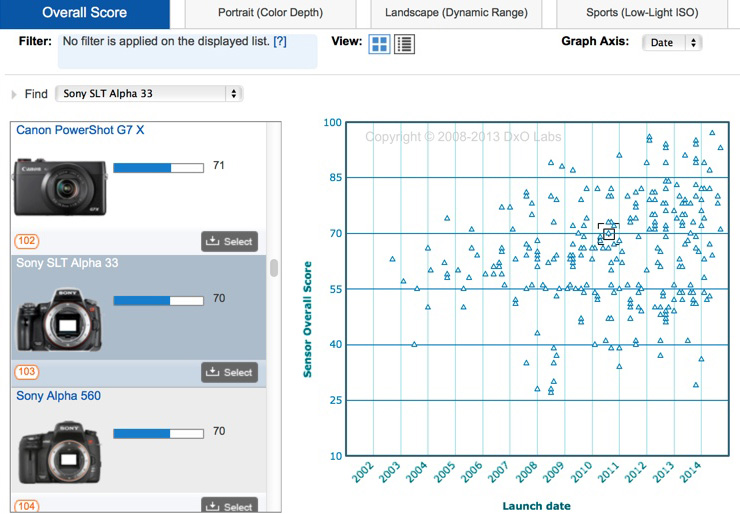

В приведённой ниже таблице собраны некоторые сведения о матрицах, использующихся в цифровых зеркальных фотоаппаратах Nikon.

Каждая строка таблицы соответствует определённой матрице. Для каждой матрицы указаны производитель и модель (за исключением тех случаев, когда модель неизвестна). Далее перечислены фотоаппараты Nikon, в которых данный сенсор когда-либо использовался (камеры, выпускающиеся в настоящее время, выделены жирным шрифтом). Затем указан период, на протяжении которого матрица (точнее, оснащаемые ей камеры) находилась (или находится) в производстве, тип матрицы, её формат, число мегапикселей и общий рейтинг качества изображения по данным DxOMark.

| Производитель и модель матрицы | Камеры | Годы выпуска | Тип матрицы | Формат | Мп | Рейтинг DxOMark |

| Sony IMX309AQJ | D850 | с 2017 | КМОП | FX | 45,4 | 100 |

| Sony IMX321 | D500, D7500 | с 2016 | КМОП | DX | 20,9 | 84-86 |

| Sony T4K54 | D5 | с 2016 | КМОП | FX | 20,8 | 88 |

| Sony IMX193AQK | D5300, D3300, D5500, D3400, D5600 | с 2013 | КМОП | DX | 24,2 | 82-86 |

| Toshiba HEZ1 TOS-5105 | D5200, D7100, D7200 | 2012-2017 | КМОП | DX | 24,2 | 83-87 |

| Sony IMX128AQP | D600, D610, D750 | с 2012 | КМОП | FX | 24,3 | 93-94 |

| Nikon NC81369R | D3200 | 2012-2014 | КМОП | DX | 24,2 | 81 |

| Sony IMX094AQP | D800, D810 | 2012-2017 | КМОП | FX | 36,3 | 95-97 |

| Nikon NC81366W | D4, D4s, Df | с 2012 | КМОП | FX | 16,2 | 89 |

| Sony IMX071 | D7000, D5100 | 2010-2013 | КМОП | DX | 16,2 | 80 |

| Nikon NC81362A | D3100 | 2010-2012 | КМОП | DX | 14,2 | 67 |

| Nikon NC81361A | D3s | 2009-2011 | КМОП | FX | 12,1 | 82 |

| Sony IMX028 (?) | D3X | 2008-2012 | КМОП | FX | 24,5 | 88 |

| Sony IMX038BQL | D90, D5000, D300s | 2008-2014 | КМОП | DX | 12,3 | 70-73 |

| Sony IMX038BQL | D300 | 2007-2009 | КМОП | DX | 12,3 | 67 |

| Nikon NC81338L | D3, D700 | 2007-2012 | КМОП | FX | 12,1 | 81 |

| Sony ICX493AQA | D80, D40x, D60, D3000 | 2006-2010 | ПЗС | DX | 10,2 | 61-65 |

| Sony ICX483AQA | D200 | 2005-2007 | ПЗС | DX | 10,2 | 64 |

| Sony IMX007AQ | D2X, D2Xs | 2004-2008 | КМОП | DX | 12,2 | 59 |

| Sony ICX453AK | D70, D70s, D50, D40 | 2004-2009 | ПЗС | DX | 6,1 | 50-56 |

| Nikon JFET-LBCAST | D2H, D2Нs | 2003-2007 | LBCAST | DX | 4,1 | 40 |

| Sony ICX413AQ | D100 | 2002-2005 | ПЗС | DX | 6,1 | — |

| Sony | D1X | 2001-2004 | ПЗС | DX | 5,3 | — |

| Sony | D1, D1H | 1999-2003 | ПЗС | DX | 2,7 | — |

Очевидно, что основным поставщиком сенсоров для фотоаппаратов Nikon является компания Sony, однако время от времени Nikon использует матрицы собственного производства. Впрочем, некоторые матрицы Nikon (NC81338L, NC81361A, NC81362A, NC81366W и NC81369R) были лишь спроектированы инженерами Nikon, а их непосредственным производством занималась компания Renesas.

Впрочем, некоторые матрицы Nikon (NC81338L, NC81361A, NC81362A, NC81366W и NC81369R) были лишь спроектированы инженерами Nikon, а их непосредственным производством занималась компания Renesas.

В фотокамерах D5200, D7100, D7200 установлен сенсор Toshiba. В 2015 году Sony скупила заводы Toshiba, занимающиеся производством фотоматриц, и потому в качестве производителя матрицы T4K54, используемой в фотоаппарате Nikon D5, указан нынешний владелец завода, на котором она выпускается, т.е. Sony, несмотря на то, что раньше этот завод принадлежал Toshiba.

Мне неизвестны модели сенсоров, использовавшихся в первых цифровых зеркальных фотоаппаратах Nikon – D1, D1H и D1X. Кроме того, я не вполне уверен: точно ли в Nikon D3X устанавливалась та же самая матрица Sony IMX028, что и в Sony α900.

Для некоторых сенсоров общий рейтинг матрицы DxOMark указан в виде диапазона. Это связано с тем, что качество изображения зависит не только от самой матрицы, но и от сопутствующей ей электроники (АЦП, процессор и пр. ), а также от алгоритмов первичного шумоподавления и оцифровки сигнала. Вследствие этого у разных фотокамер, оснащённых одним и тем же сенсором, качество изображения может незначительно различаться. Например, общий рейтинг DxOMark для Nikon D810 составляет 97 баллов, а для Sony A7R – 95 баллов, хотя матрица в обеих камерах одна и та же – Sony IMX094AQP. Иными словами, Nikon ухитряется добиваться от сенсоров Sony большей производительности, чем это получается у самой Sony.

), а также от алгоритмов первичного шумоподавления и оцифровки сигнала. Вследствие этого у разных фотокамер, оснащённых одним и тем же сенсором, качество изображения может незначительно различаться. Например, общий рейтинг DxOMark для Nikon D810 составляет 97 баллов, а для Sony A7R – 95 баллов, хотя матрица в обеих камерах одна и та же – Sony IMX094AQP. Иными словами, Nikon ухитряется добиваться от сенсоров Sony большей производительности, чем это получается у самой Sony.

Спасибо за внимание!

Василий А.

Post scriptum

Если статья оказалась для вас полезной и познавательной, вы можете любезно поддержать проект, внеся вклад в его развитие. Если же статья вам не понравилась, но у вас есть мысли о том, как сделать её лучше, ваша критика будет принята с не меньшей благодарностью.

Не забывайте о том, что данная статья является объектом авторского права. Перепечатка и цитирование допустимы при наличии действующей ссылки на первоисточник, причём используемый текст не должен ни коим образом искажаться или модифицироваться.

Желаю удачи!

Дата публикации: 14.01.2016 |

Вернуться к разделу «Фотооборудование»

Перейти к полному списку статей

Антимаркетинг: сравниваем камеры популярных смартфонов

Производители смартфонов прибегают к разным трюкам, показывая возможности встроенных камер и «забывая» сказать, почему вы вряд ли получите аналогичный результат. Мы попробуем подкинуть пищу для размышлений и помочь вам противостоять такой недобросовестной рекламе.

Методика тестирования

В этой статье сравниваются самые ходовые модели 2018 – 2019 года выпуска из среднего ценового сегмента. Формально в него же попадают и подешевевшие флагманы прошлых лет, но давайте ограничимся смартфонами одного исходного класса.

За снимками обратимся к специалистам из GSMArena. Они тестируют камеры смартфонов с 2010 года и накопили очень внушительную базу. Обычному покупателю будет сложно понять результат из тестовых таблиц, поэтому мы сделаем необходимые пояснения.

В сравнении принимают участие только основные (тыловые) камеры, работающие в автоматическом режиме при съёмке одиночных кадров цветных постеров и специальной тестовой карточки – фотографической миры PIMA/ISO 12233.

На всех смартфонах отключены бьюти-фильтры, искусственный недоинтеллект и прочие улучшалки, а где это возможно – установлен стиль изображения «точное». Смартфоны установлены на штатив. Делается серия кадров, из которой вручную выбирается самое резкое изображение. Для полноты картины съёмка повторяется в условиях нормальной и низкой освещённости. Значения ISO и выдержки, а также баланс белого устанавливаются камерами автоматически.

Матрицы и фокусные расстояния у всех разные, поэтому размер изображения тоже будет отличаться. Мы приводим идентичные фрагменты исходных кадров в формате PNG безо всякого масштабирования.

Мы приводим идентичные фрагменты исходных кадров в формате PNG безо всякого масштабирования.

Оптическое разрешение

Если говорить о макро-режиме при ярком освещении, то здесь на разрешение больше всего влияет объектив. У всех смартфонов среднего уровня оптика одного класса, поэтому оно примерно одинаковое и находится в районе 12 – 16 линий на миллиметр. Вот как это выглядит на оказавшейся под рукой координатной сетке для цифровых микроскопов (100% кроп без обработки с 12 МП матрицы при ISO 100, съёмка со штатива).

Координатная сетка с шагом 0,1 мм (кликните, чтобы открыть на отдельной вкладке).

Между рисками миллиметровой шкалы есть ещё девять тонких линий (цена деления 0,1 мм), и они чётко видны. 20 и более линий на миллиметр (lpmm) смартфон уже не покажет – они просто визуально сольются.

При обычной съёмке (с расстояния 40 см и более) широкоугольный объектив смартфона не способен передать мелкие детали из-за их малого углового размера. На общее восприятие картинки в большей степени влияет уже матрица, а она в любом смартфоне оставляет желать лучшего из-за очень низкого соотношения сигнал/шум. Алгоритмы шумоподавления всегда скрадывают детализацию. Теряется текстура, а эффективное разрешение падает до пары линий на миллиметр.

Алгоритмы шумоподавления всегда скрадывают детализацию. Теряется текстура, а эффективное разрешение падает до пары линий на миллиметр.

Вообще измерение оптического разрешения камеры – довольно сложная и дорогая задача. Мы возьмём профессиональные таблицы, но не будем вас мучить математикой. Просто скажем, что коэффициент пересчёта в lpmm для них составляет 0,075. То есть, если вы видите отдельные линии до маркера «20», а на промежуточной отметке «22» они уже слились, значит – разрешение составит полторы линии на миллиметр.

Насколько это много? Такая характеристика типична для цифромыльниц, которые сегодня вытеснили смартфоны. Системные камеры и зеркалки любительского уровня со съёмным объективом в комплекте обычно дают 20-30 lpmm (в самой резкой зоне по центру), а профессиональные – до 100 lpmm, но разглядеть это великолепие можно только при использовании полнокадровых и среднеформатных матриц. В смартфоне такие просто негде разместить.

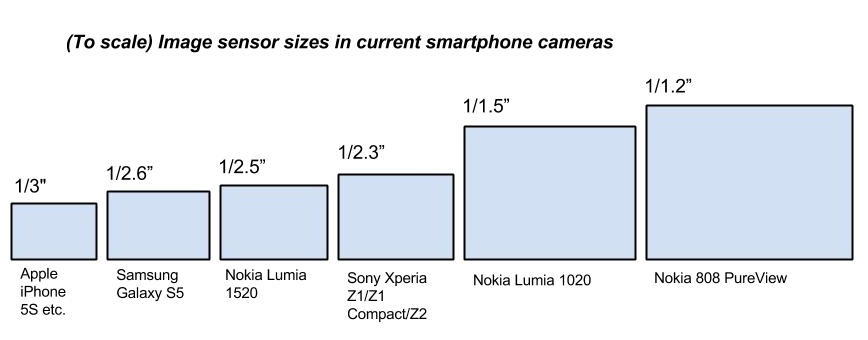

Сравнение физических размеров матриц у смартфонов и разной фототехники (картинка кликабельна).

Оценка результатов

В верхнем ряду каждого снимка представлена пара фрагментов миры. Смотрим, где линии впервые видны по-отдельности. Настолько чётко, что их легко сосчитать. Чем левее (больше значение в подписи), тем выше реальная разрешающая способность камеры. Для наглядного сравнения относительных результатов этого достаточно, а определение точных частотно-контрастных характеристик оставим лабораториям, специализирующимся на оптике.

Второй ряд демонстрирует цветную вышивку на сером фоне. Он хорошо показывает степень детализации изображения и характер его огрубления при съёмке в полутьме.

Третий ряд показывает точность автофокуса на цветном фоне и качество цветопередачи в разных условиях освещения. Некоторые смартфоны искусственно усиливают яркость и/или насыщенность отдельных оттенков, делая цвета неестественными.

Huawei P Smart (2019)

Характеристики камеры: 13 MP, f/1.8, PDAF (подробнее см. раздел «Краткий словарь терминов»).

раздел «Краткий словарь терминов»).

(кликните для увеличения)

У Huawei P Smart (2019) камера «мылит» вплоть до отметки «24». Действительно отдельными линии начинают восприниматься с промежуточного маркера 22 и далее (подробнее см. раздел «Оптическое разрешение»). Точнее трудно сказать из-за того, что изображение слегка не в фокусе (напомню, что это лучшая попытка в серии). Автофокус у P Smart явно оставляет желать лучшего.

Правый верхний угол снимка показывает диапазон яркости камеры. На нём видны провалы в тенях. Полутона после отметки 15 сливаются в сплошной чёрный. Впрочем, это совершенно типичный результат для смартфонов. Немного расширить диапазон яркости поможет съёмка в HDR (только статичных объектов со штатива) или в RAW (хотя у смартфонов это повышает разрядность каждого канала всего до 10-12 бит, а не до 14 бит, как у зеркалок).

Пара изображений посередине демонстрирует детализацию при минимальном ISO (слабое или выключенное шумоподавление) и высоком ISO (сильное шумоподавление). На левой картинке текстура вышивки сильно смазана (отчасти это объясняется и небольшой промашкой автофокуса), а на правой сглаживание затронуло даже крупные стежки. Также ожидаемо видим ухудшение цветопередачи – серые вертикальные линии теперь выглядят зелёными (цвета окружающего их фона).

На левой картинке текстура вышивки сильно смазана (отчасти это объясняется и небольшой промашкой автофокуса), а на правой сглаживание затронуло даже крупные стежки. Также ожидаемо видим ухудшение цветопередачи – серые вертикальные линии теперь выглядят зелёными (цвета окружающего их фона).

Вообще с цветопередачей тёмных полутонов у Huawei P Smart (2019) дела обстоят неважно, особенно на высоких значениях ISO. Это видно и на картинке с цветными карандашами, где тёмно-зелёный и тёмно-синий грифель на ISO 64 ещё хоть как-то различимы, а при ISO 800 уже выглядят практически одинаково чёрными. Баланс белого также далёк от идеального. Серый фон миры в левом верхнем углу имеет зеленоватый оттенок.

Huawei P20 Lite

Камера: 16 MP, f/2.2, PDAF

(кликните для увеличения)

У P20 lite лучше сработал автофокус (изображение более резкое), однако из-за мелких пикселей (1,0 мкм) видим сильные цветовые шумы. В результате их подавления итоговое разрешение снимка даже чуть ниже, чем у P Smart – до маркера «20» линии сливаются.

На высоких ISO ослик выглядит бледным и зернистым даже в районе гладкой серой вставки. Кстати, ISO пришлось поднимать до 1000 единиц – сказывается сравнительно низкая светосила объектива.

Зато баланс белого очень хорош, а вертикальные полоски седла в полутьме сохранили настоящий серый цвет – огрубление цветопередачи у P20 Lite не такое сильное. При хорошей освещённости картинка и вовсе радует – угадываются средние по размеру стежки, а на карандашах можно разглядеть текстуру.

Huawei Mate 20 lite

Камера: 20 MP, f/1.8, PDAF.

(кликните для увеличения)

Число мегапикселей растёт, а эффективная разрешающая способность в лучшем случае остаётся такой же. При ярком освещении все изображения выглядят презентабельно. Цвета не вызывают каких-то сомнений, хотя баланс белого слегка смещён в область более низкой цветовой температуры (серый выглядит желтоватым).

При слабом освещении автофокус промахнулся – вышивка получилась очень смазанной и бледной. Цвета поплыли: серый фон порозовел, а тёмно-зелёный стал более синим (бирюзовым). От текстуры дерева не осталось и следа. В полутьме таким смартфоном даже не стоит пытаться фотографировать.

Цвета поплыли: серый фон порозовел, а тёмно-зелёный стал более синим (бирюзовым). От текстуры дерева не осталось и следа. В полутьме таким смартфоном даже не стоит пытаться фотографировать.

Honor 8X

Камера: 20 MP, f/1.8, PDAF

(кликните для увеличения)

Казалось бы, имеем те же 20 мегапикселей при диафрагме 1.8 и то же разрешение, но в итоге получаем немного другой результат. Баланс белого смещён в противоположную сторону: занижен синий канал и слегка завышен зелёный. Провалы в тенях чуть глубже – уже с маркера «13» всё сливается в чёрный. Зато автофокус точнее сработал, из-за чего вышивка выглядит детальнее – очень чёткие края. На высоких ISO изображение такое же замыленное, а серые стежки на зелёном фоне опять стали зелёными.

Honor 10 Lite

Камера: 13 MP, f/1.8, PDAF.

(кликните для увеличения)

Облегчённая версия десятого «Хонора» вытягивает разрешение до отметки «24» и даже чуть больше, но тёмные полутона сливаются как у всех. Баланс белого слегка смещён в сторону тёплых оттенков. Сами цвета выглядят естественно. Детализация средняя при хорошем освещении. Съёмка в темноте чуть лучше по сравнению с 8X – текстуры сглаживаются, но не пропадают. Тонкие серые полосы также стали зелёными, края объектов заметно размыты из-за сильного шумоподавления.

Баланс белого слегка смещён в сторону тёплых оттенков. Сами цвета выглядят естественно. Детализация средняя при хорошем освещении. Съёмка в темноте чуть лучше по сравнению с 8X – текстуры сглаживаются, но не пропадают. Тонкие серые полосы также стали зелёными, края объектов заметно размыты из-за сильного шумоподавления.

Motorola (Lenovo) Moto G6

Камера: 12 MP, f/1.8, PDAF.

(кликните для увеличения)

Отдельные линии видны от промежуточного маркера 22. При 12 Мп эффективное разрешение снимков почти такое же, как у Huawei Mate 20 lite с его 20 Мп сенсором. Сказывается увеличенный размер пикселей (1,4 мкм), дающий сравнительно низкие шумы.

Баланс белого плывёт в сторону низкой цветовой температуры (слегка желтит). Провалы в тенях довольно глубокие (столбики градиентной заливки 14 – 19 сливаются). Текстура карандашей немного смазана, цвета естественные.

При ярком освещении вышивка выглядит очень детально: видно даже мелкие стежки. Это один из самых резких кадров в обзоре. На высоких ISO автофокус наводится точнее, чем у большинства смартфонов, но сглаживание и огрубление цветопередачи при этом сильнее заметны.

Nokia 7.1

Камера: 12 MP, f/1.8, Dual Pixel PDAF

(кликните для увеличения)

Главное отличие – технология улучшенного фазового автофокуса. Как плоские, таки и объёмные предметы на всех снимках очень чёткие. Эффективное разрешение аналогично Moto G6 – линии сливаются в районе маркера «22».

Алгоритм подавления яркостных шумов здесь менее агрессивный, поэтому сравнительно высокая детализация сохраняется даже на высоких значениях ISO. Цвета почти не бледнеют и слабо искажаются – серые полоски на зелёном фоне остаются серыми.

Samsung Galaxy A7 (2018)

Камера: 24 МP, f/1.7, PDAF

(кликните для увеличения)

Работу автофокуса трудно назвать образцовой – фотографии карандашей смазаны даже при съёмке в условиях яркого освещения. Оптическое разрешение камеры весьма радует: отдельные линии видны вплоть до маркера «28», хроматических аберраций невооружённым глазом не наблюдается.

Очень заметна светосильная оптика: в то время как другие смартфоны поднимают ISO до 800 – 1000 единиц, A7 в тех же условиях достаточно 400. Как результат – меньше яркостных шумов и чище картинка.

Однако алгоритмы цветового шумоподавления зачем-то сделали очень агрессивными – текстура карандашей пропала полностью даже при ISO50, вместо рисунка дерева видно только мутные пятна. Мелкие стежки на вышивке превратились в группу артефактов. Вот так на уровне софта можно угробить хорошую аппаратную платформу.

Xiaomi RedMi Note 7

Камера: 48 MP, f/1.8, PDAF

(кликните для увеличения)

С яркостным диапазоном у этой камеры всё как обычно, поэтому мы пропустим 50 оттенков серого, чтобы показать иллюзию 48 мегапикселей за счёт технологии Quad Bayer Array. Здесь её работа отчётливо видна в верхнем ряду.

Повышение количества пикселей матрицы в четыре раза никак не влияет на реальное оптическое разрешение: на обоих снимках линии сливаются за маркером 22. Более того, на них очень заметны хроматические аберрации – это кривая работа алгоритма интерполяции «тетрапикселей» (см. Краткий словарь терминов) на этапе дематризации.

Автофокус не смог точно навестись на резкость, поэтому даже при хорошем освещении мелкие детали смазываются. Текстура карандашей выглядит как артефакты пикселизации. С таким же успехом вы можете растянуть вчетверо картинку, снятую на Honor 8X, Moto G6 или Nokia 7.1.

Xiaomi Mi8 Lite

Камера: 12 МP, f/1.9, Dual Pixel PDAF

(кликните для увеличения)

Оптическое разрешение чуть выше среднего для группы прямых конкурентов – линии сливаются за маркером «22». Диапазон яркости максимальный для восьмибитной растровой картинки – различимы все градиентные столбики до маркера 16 (B) включительно.

Радуют щадящие алгоритмы шумоподавления. На всех снимках хорошо видна текстура и мелкие детали. Их можно разглядеть даже на ISO 800, что большая редкость.

Баланс белого смещён в сторону жёлто-зелёного оттенка. Автофокус Dual Pixel PDAF работает менее точно, чем аналогичный у Nokia 7.1.

Краткий словарь терминов

PDAF – Phase Detection Auto Focus, фазовый автофокус. Для проверки автоматической фокусировки в нём определяется схождение лучей из нескольких точек с центра и краёв объектива. В «зеркалках» он работает шустро и довольно точно, а в телефонах – гораздо хуже из-за габаритных ограничений. В темноте часто промахивается, так как часть лучей просто не фиксируется и проверить их сходимость не удаётся.

Dual Pixel PDAF – улучшенный фазовый автофокус, в котором для оценки резкости используется почти вся площадь матрицы. Гораздо быстрее и точнее PDAF. Разница особенно заметна при низкой освещённости.

Laser AF – лазерный автофокус. Работает как лазерный дальномер. Объект съёмки подсвечивается ИК-лазером, после чего оценивается время получения отражённого от него света. По этим данным вычисляется расстояние до объекта, а блок линз быстро перемещается на заранее заданную величину. В целом работает быстрее PDAF и даёт меньше ошибок (особенно в темноте), но из-за низкой мощности лазера его заявленная дальность ограничена пятью метрами, а реально эффективная – двумя-тремя.

f/x.y – диафрагменное число, или просто диафрагма. Показывает светопропускание объектива через отношение входного зрачка объектива (принимается за единицу) к заднему фокусному расстоянию. У смартфонов регулируемой диафрагмы нет, поэтому f принимается соответствующим её максимально открытому положению. Условно говоря, чем меньше знаменатель – тем лучше. Например, камера с f/1.8 пропускает за единицу времени больше света (обладает большей светосилой), чем с f/2.2. В одинаковых условиях первая будет снимать на более коротких выдержках и/или устанавливать меньшее значение ISO, что положительно скажется на качестве снимка.

ISO – светочувствительность матрицы, оцениваемая по стандарту ISO 12232:2006. Чем выше ISO, тем при более низкой освещённости можно снимать, но достигается это ценой повышения яркостных шумов. На ISO 50 – 200 эти шумы незначительны и картинка выглядит максимально чёткой. На ISO 800 и выше включаются алгоритмы агрессивного шумоподавления, из-за чего изображение становится блёклым и сильно сглаженным. Мелкие детали теряются полностью, цветопередача огрубляется.

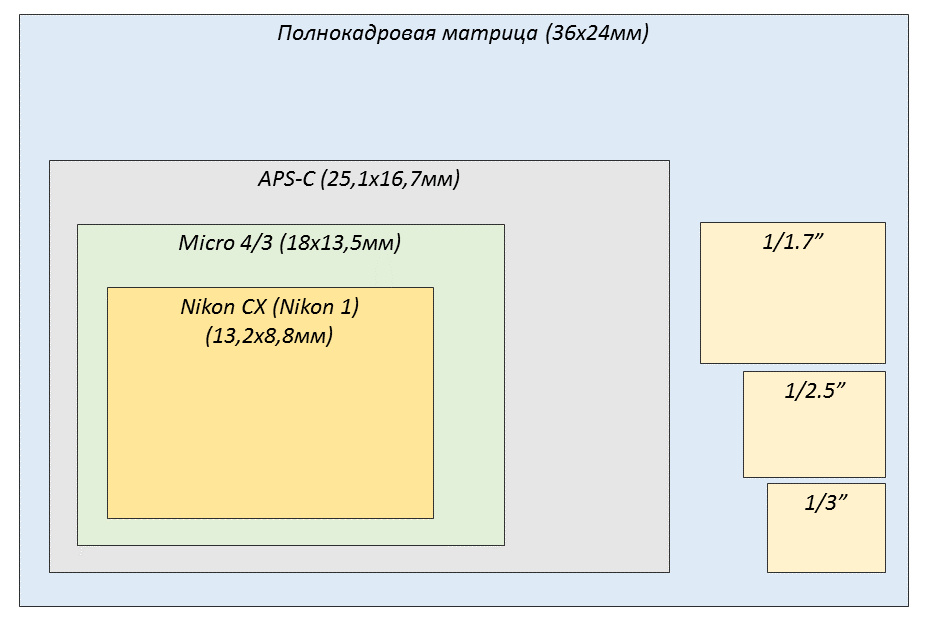

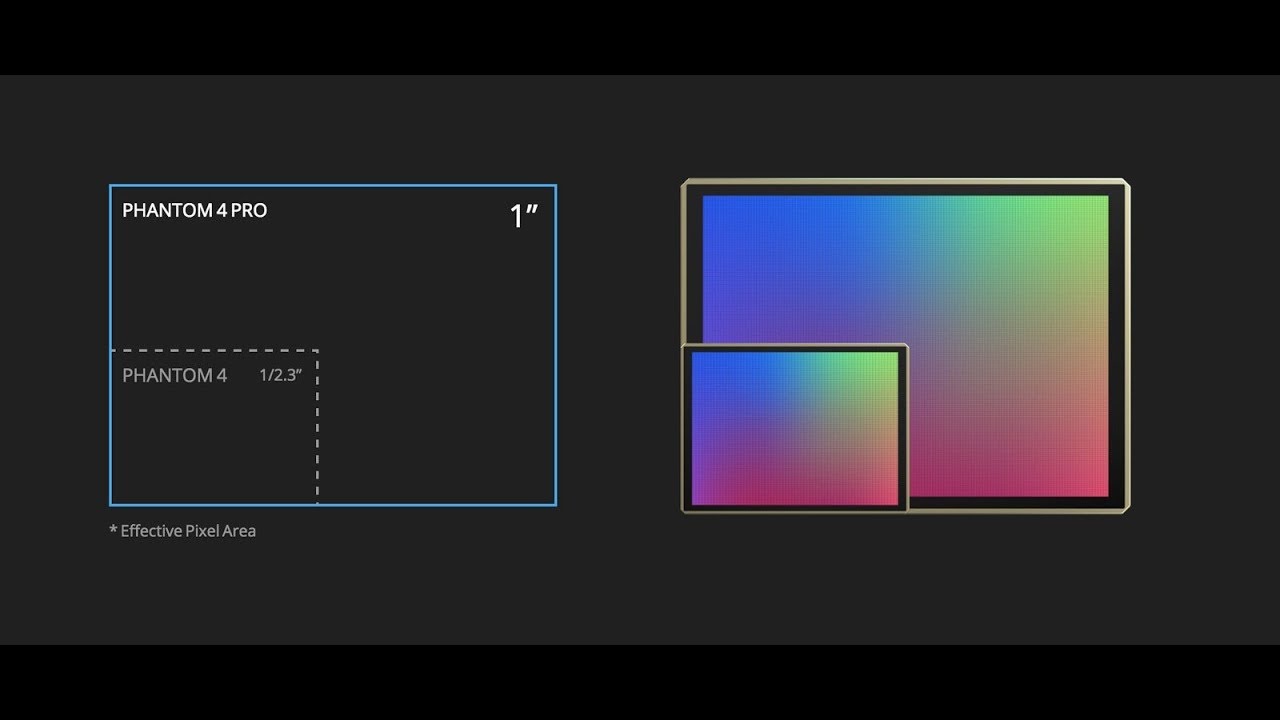

1/x.y» – эквивалентный размер матрицы. Чем меньше число в знаменателе, тем крупнее матрица (см таблицу в начале статьи). Сами пиксели (при одинаковом разрешении) тоже крупнее, поэтому ниже уровень цветовых шумов. Проще говоря, в пределах одного поколения матрица 1/1.7″ даёт более детальное изображение, чем 1/2.7″.

X мм – фокусное расстояние в эквиваленте кадра 35-мм плёнки. Чем меньше это значение, тем более широкий угол обзора у камеры. Больше объектов влезает в кадр ценой усиления геометрических искажений.

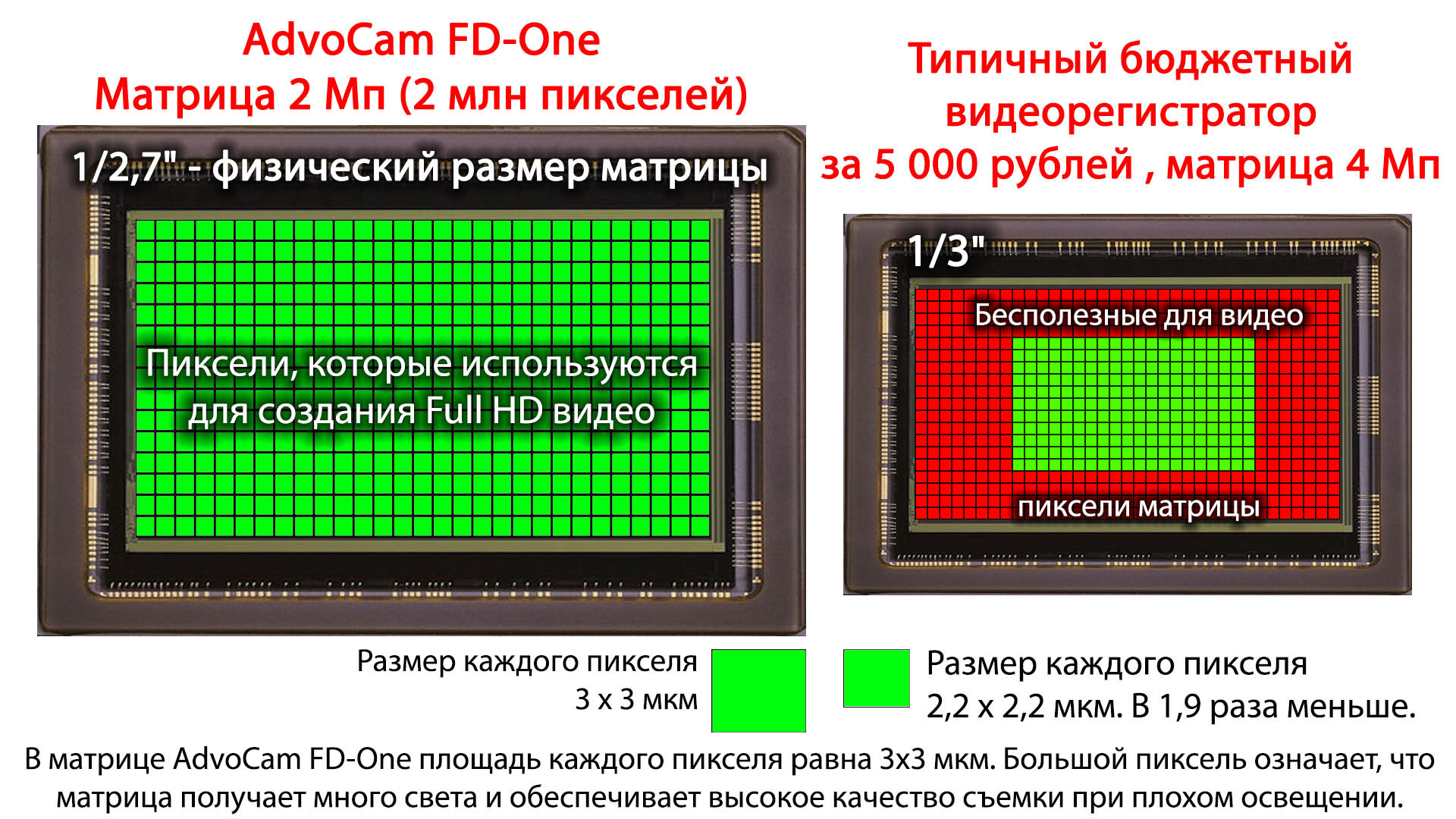

MP – разрешение матрицы в мегапикселях (миллионах точек). Правило «чем больше, тем лучше» здесь работает только до определённого предела – пока размер пикселей не станет слишком мелким. Сейчас у лучших матриц для смартфонов пиксели от 1,2 мкм и более, но обратите внимание: 1,6 мкм обычно указывается как маркетинговый ход. У современных матриц 40 MP эквивалентны десяти «тетрапикселям» – квадрату из четырёх пикселей под общим светофильтром одного цвета (технология Quad Bayer Array). Здесь 1,6 мкм – сторона квадрата. Нетрудно подсчитать, что размер одного пикселя составляет 0,8 мкм.

Выводы

В нашем кратком сравнении участвовали десять смартфонов с матрицами от 12 до 48 Мп. С лёгкой руки маркетологов большинство покупателей считают, что чем больше мегапикселей, тем лучше изображение. Возможно, это и было так на заре цифровой фотографии (разница между 0,3 и 3 Мп действительно не вызывает сомнений), но сейчас дальнейшая гонка за разрешением КМОП-сенсора у смартфонов потеряла смысл. Картинка просто становится крупнее, а вот будет ли она детальнее – зависит совершенно от других факторов. Главные из них – свойства оптической системы, физические размеры матрицы и алгоритмы обработки.

Каждый элемент объектива вносит свои оптические аберрации, а процессор обработки изображений ещё сильнее искажает картинку, пытаясь подавить цифровой шум. Особенно это заметно на крошечных матрицах смартфонов. В какой-то момент достигается предел разрешающей способности системы, и вы больше не увидите новых деталей, как бы сильно ни увеличивали фотографию. Первые «зеркалки» с матрицами 3 – 5 Мп и нормальным объективом до сих пор снимают лучше любого смартфона, будь в нём хоть 48 миллионов подслеповатых наноглаз.

Гораздо большее значение для смартфона имеет система автофокуса, светосила и настройка программных алгоритмов шумоподавления. Большинство кадров снимаются с рук, поэтому оптическая стабилизация очень выручит. Если же её нет, или она формальная – добавьте света (это укоротит выдержку и/или ISO, сделав снимок чётче и чище), либо воспользуйтесь штативом.

Баланс белого не совсем корректно определяется всеми смартфонами даже в идеальных условиях съёмки, поэтому по возможности снимайте в RAW. Тогда при постобработке вы просто укажите нужную цветовую температуру, и все полутона автоматически исправятся без потерь. Также этот формат позволит вам немного увеличить диапазон яркости и скорректировать свет/тень без появления заметных артефактов.

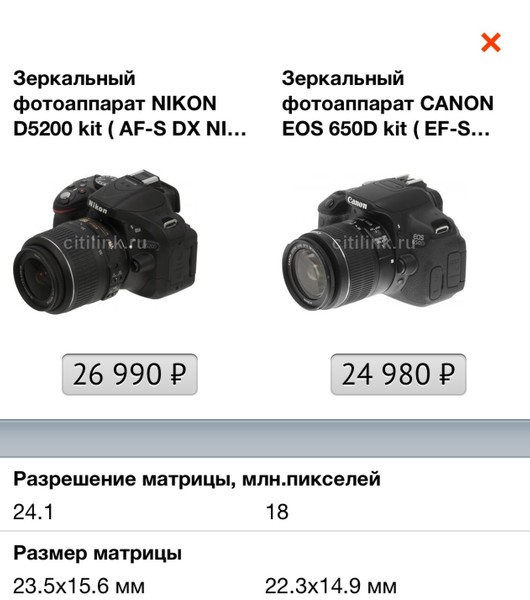

Какая матрица для фотоаппарата лучше: как выбрать

Покупая фотоаппарат, неважно какой: профессионального класса или рядовой бюджетный компакт для съемок друзей и семьи на природе, хочется, чтобы снимки получались качественными, а сам аппарат давал как можно больше свободы. Зная, какая матрица для фотоаппарата лучше, можно не впадать в ступор в магазине при виде двух моделей разных марок, которые выглядят одинаково, но стоят очень по-разному. Все дело в сенсоре, который и отвечает за то, какое изображение будет получаться и насколько гибкие рамки пользования фотоаппаратом будут у владельца.

Немного технических сведений

Матрицы цифровых фотоаппаратов делятся на два основных типа по применяемым полупроводникам и технологии считывания информации.

- Тип матрицы ПЗС (CCD) – самый распространенный. Это достаточно дешевая технология, информация об изображении считывается последовательно с каждой ячейки.

- КМОП матрицы CMOS дороже, но эффективнее в плане скорости работы, поскольку позволяют считывать данные сразу со всех светочувствительных элементов. Такие сенсоры устанавливаются в дорогих камерах, поскольку ни один производитель не пройдет мимо шанса предоставить пользователю возможности съемки с очень малыми выдержками, что в свою очередь усложняет аппаратно-программный комплекс.

Большинство фотоаппаратов пользовательского класса оснащено ПЗС матрицами. При этом ставится вполне ожидаемое условие: для получения действительно качественных снимков при естественном освещении (или при недостаточном) лучше использовать штатив, поскольку время выдержки будет значительным. Аналогично – не получится делать снимки крайне быстро, поскольку нужно время на получение и обработку изображения.

Некоторые производители решают последнюю проблему достаточно просто: оснащают фотоаппараты буфером памяти. Туда помещаются кадры до обработки, когда ведется съемка в так называемом спортивном режиме – серией за короткий промежуток времени.

Дорогие фотокамеры, оснащенные КМОП матрицами, позволяют делать снимки “с рук” с малой выдержкой, имеют высокую светочувствительность и низкий уровень шума. С помощью такого оборудования можно проводить экспонометрию, снижается время автофокусировки, естественно, легко сделать хороший кадр.

Еще одна технология, которая применяется в самой дорогой фототехнике – многослойные матрицы. Это не очередной пункт в списке «виды матриц». Светочувствительная зона таких аппаратов состоит из трех слоев ПЗС, каждый из которых считывает только один цвет. В результате качество изображения просто потрясает. Техника с данной технологией особо маркируется: 3CCD.

Последнее, что стоит упомянуть, – технологические размеры матриц. ПЗС сенсоры можно сделать маленькими, они построены на кремниевых элементах. А КМОП матрицы достаточно большие, что является еще одним рациональным доводом в пользу их применения в дорогой профессиональной технике.

Количественный показатель качества

Задавая себе вопрос, какая матрица фотоаппарата лучше,- можно достаточно быстро получить ответ без необходимости вникать в технологические особенности. Обратите внимание на следующие характеристики:

- заявленное количество мегапикселей в характеристике камеры;

- эффективное количество пикселей, которое ответственные производители указывают в документации к фотоаппарату;

- возможные размеры изображений, которые можно делать с помощью камеры.

Производители дешевых моделей фотоаппаратов часто лукавят, указывая, прежде всего, размерность картинки и выставляя огромные цифры как эффективный рекламный ход. Это не говорит о качестве получаемых снимков. Типы матриц фотоаппаратов могут быть разного класса. Однако если сенсор не имеет достаточной разрешающей способности, большие изображения на выходе будут иметь низкую детализацию и высокий уровень шума.